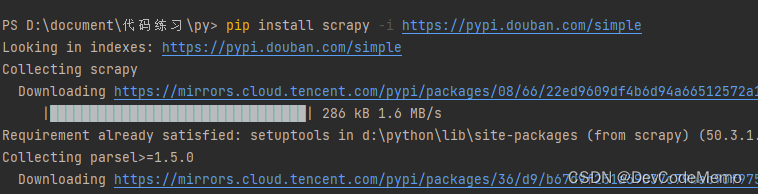

1.安装scrapy

pycharm终端运行 pip install scrapy -i https://pypi.douban.com/simple

2.终端运行scrapy startproject scrapy_baidu,创建项目

问题1:lxml版本低导致无法找到

解决措施:更新或者重新安装lxml

3.项目创建成功

4.终端cd到项目的spiders文件夹下,cd scrapy_baidu\scrapy_baidu\spiders

创建爬虫文件名百度,域名

5.爬虫文件创建成功打开,修改def parse,打印输出

6.运行爬虫文件,scrapy crawl baidu

问题2:attrs版本低

解决措施:重新安装

7.再次运行爬虫文件,scrapy crawl baidu

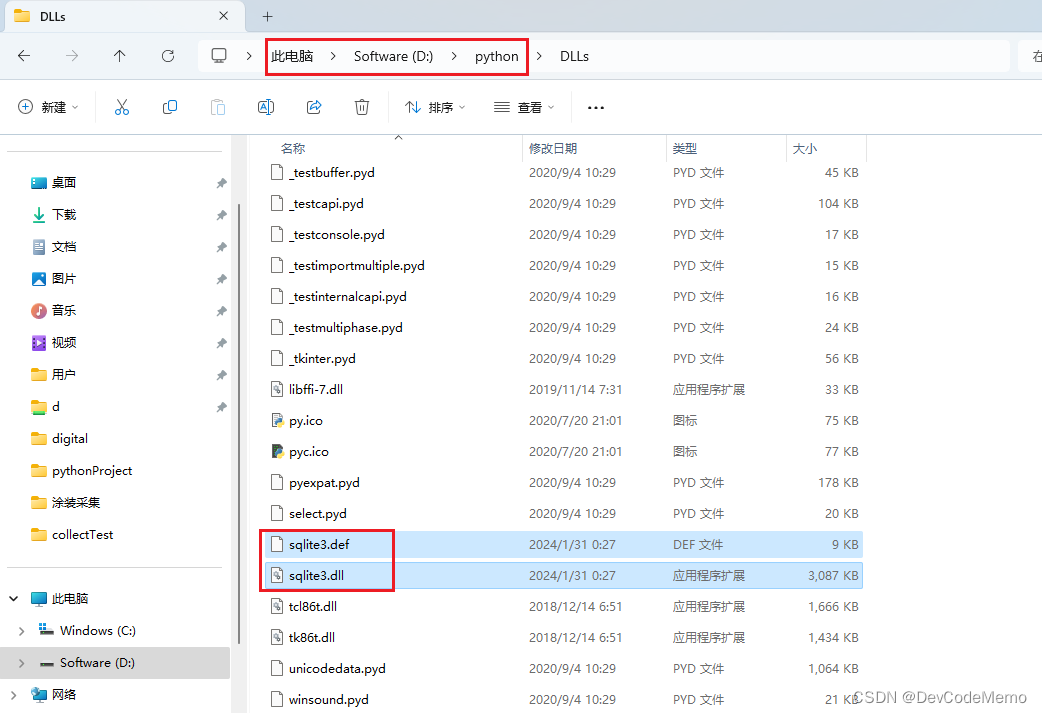

问题3:无法加载sqllite3

解决措施:下载sqllite dll文件,解压到python解释器对应DLLs文件夹下

https://www.sqlite.org/download.html

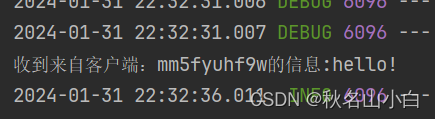

8.再次执行后成功运行打印输出

![BUUCTF-Real-[PHP]XXE](https://img-blog.csdnimg.cn/direct/e6c9ec3e656e466581df7cd3330c1030.png)

![vue3 [Vue warn]: Unhandled error during execution of scheduler flush](https://img-blog.csdnimg.cn/direct/c2a18f78e0194054b5cf912cbf43d271.png)