这里写自定义目录标题

- 参考资料

- 环境

- 算法

- CPO 2017 ICML

- PCPO 2019 ICLR

- FOCOPS 2020 NIPS

- CRPO 2021 ICML

- CUP 2022 NIPS

TRPO

如何看懂TRPO里所有的数学推导细节? - 小小何先生的回答 - 知乎

参考资料

Safe Reinforcement Learning

安全/约束强化学习路线图(Safe RL Roadmap)编辑于 2023-05-06

Safe RL 的一点点总结编辑于 2021-04-25

1.CPO

2.RCPO

3.CPPO-PID

4.SafeLayer+DDPG

5.Safety-Gym

【安全强化学习· 一】Safe Reinforcement Learning(一)2020

Constrained reinforcement learning

constrained markov decision processes

PKU-Alignment/Safe-Policy-Optimization 作者就是CUP的作者

NeurIPS 2023: Safe Policy Optimization: A benchmark repository for safe reinforcement learning algorithms

PKU-MARL/OmniSafe github

PKU-MARL/OmniSafe 作者就是CUP的作者

OpenAI/safety-starter-agents github

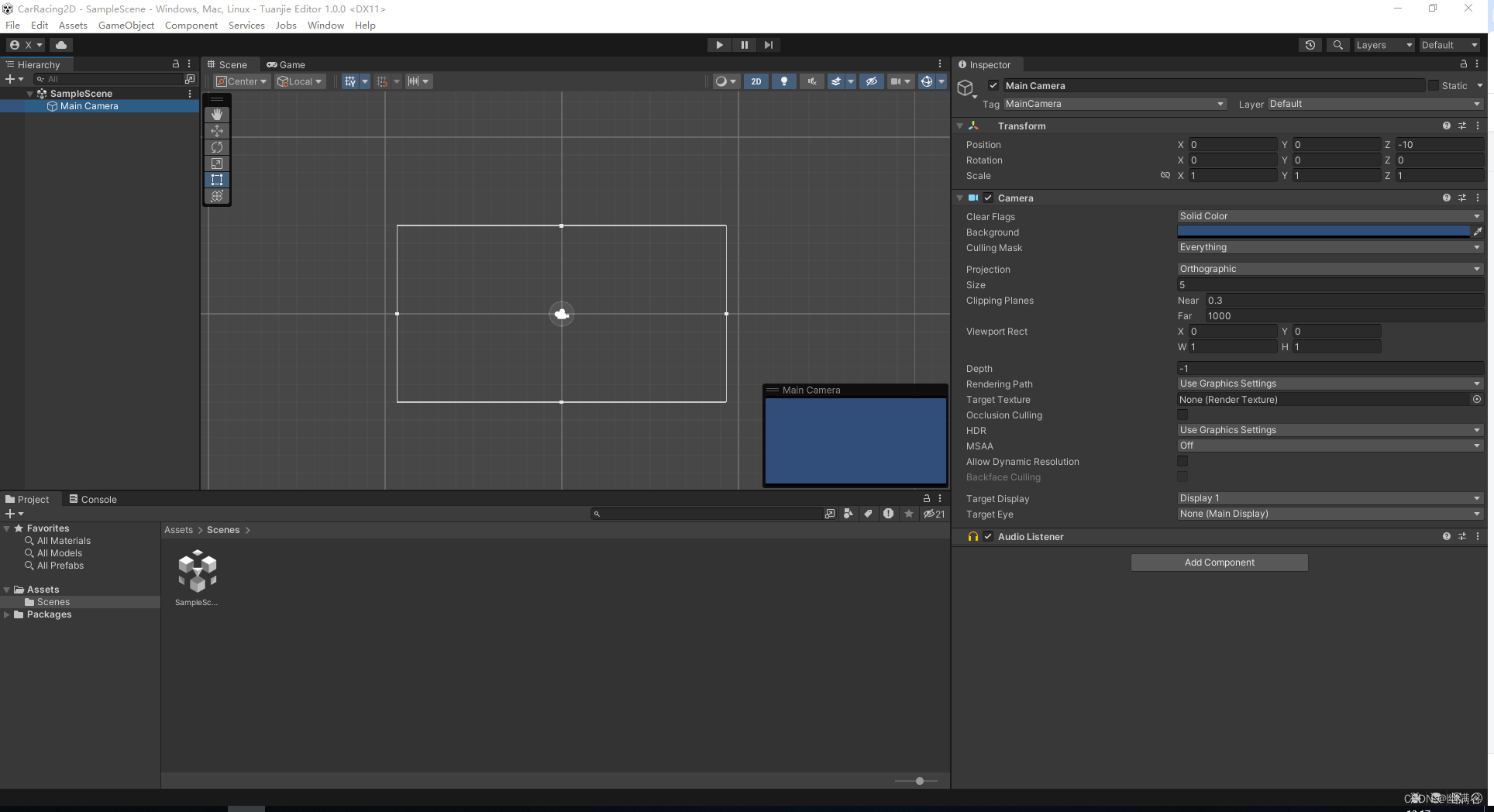

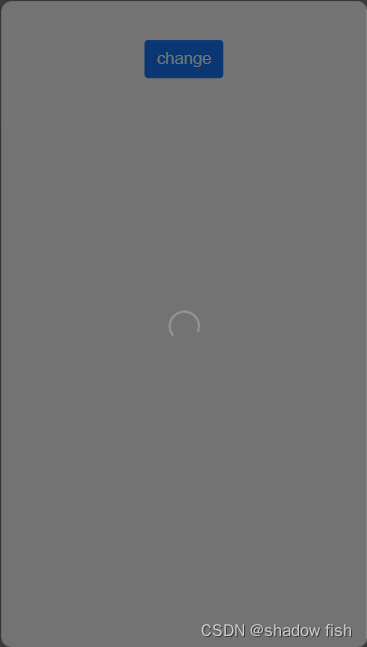

环境

safety-gym openai

Benchmarking Safe Exploration in Deep Reinforcement Learning, Ray et al, 2019.

safety-gymnasium

Bullet-Safety-Gym

算法

| 算法 | 算法 | 类型 | 时间 | 会议 | 引用量 |

|---|---|---|---|---|---|

| CPO | 约束策略优化 | 二阶 | 2017 | ICML | 1214 |

| RCPO | 奖励约束策略优化 | 2018 | ICLR | 452 | |

| PCPO | 基于投影的约束策略优化 | 二阶 | 2019 | ICLR | 188 |

| FOCOPS | 策略空间中的一阶约束优化 | 一阶 | 2020 | NIPS | 87 |

| CRPO | 约束修正策略优化 | Lagrange | 2021 | ICML | 84 |

| CUP | 约束更新投影 | 一阶 | 2022 | NIPS | 18 |

CPO 2017 ICML

Constrained Policy Optimization 上海交通大学 工学硕士

CPO omnisafe

PCPO 2019 ICLR

PCPO omnisafe

FOCOPS 2020 NIPS

FOCOPS slideslive

FOCOPS slideslive 短

FOCOPS omnisafe

CPO的问题

从当前策略获取样本轨迹时产生的错误。

泰勒近似引起的近似误差。

使用共轭法计算Fisher信息矩阵的逆矩阵会产生近似误差。

FOCOPS的优势

实现简单,只使用一阶近似。

简单的一阶法避免了泰勒法和共轭法引起的误差。

在实验中表现优于CPO。

不需要任何恢复步骤。

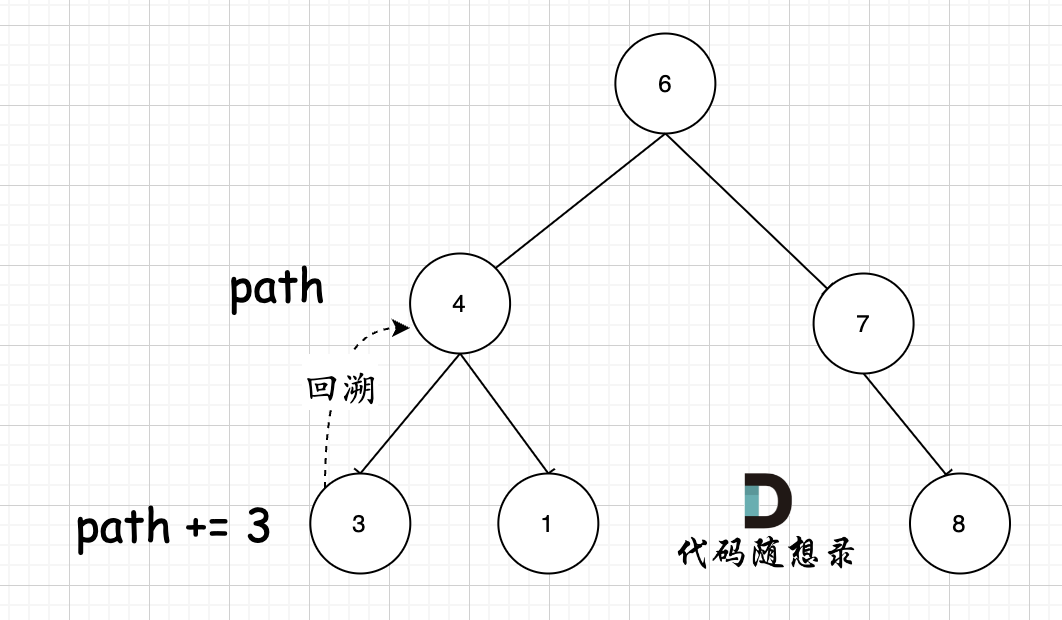

Two-stage Policy Update

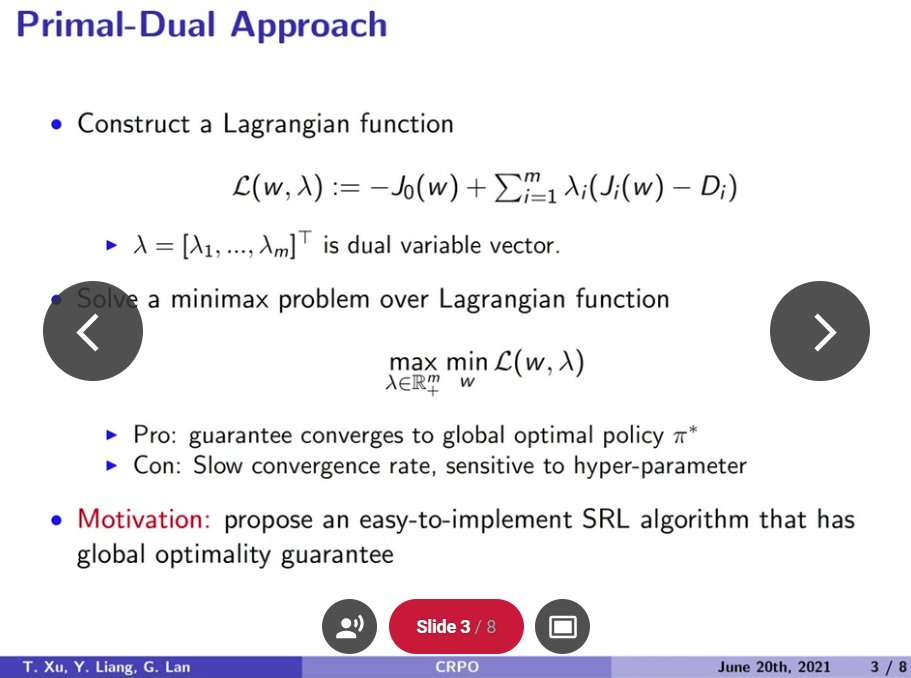

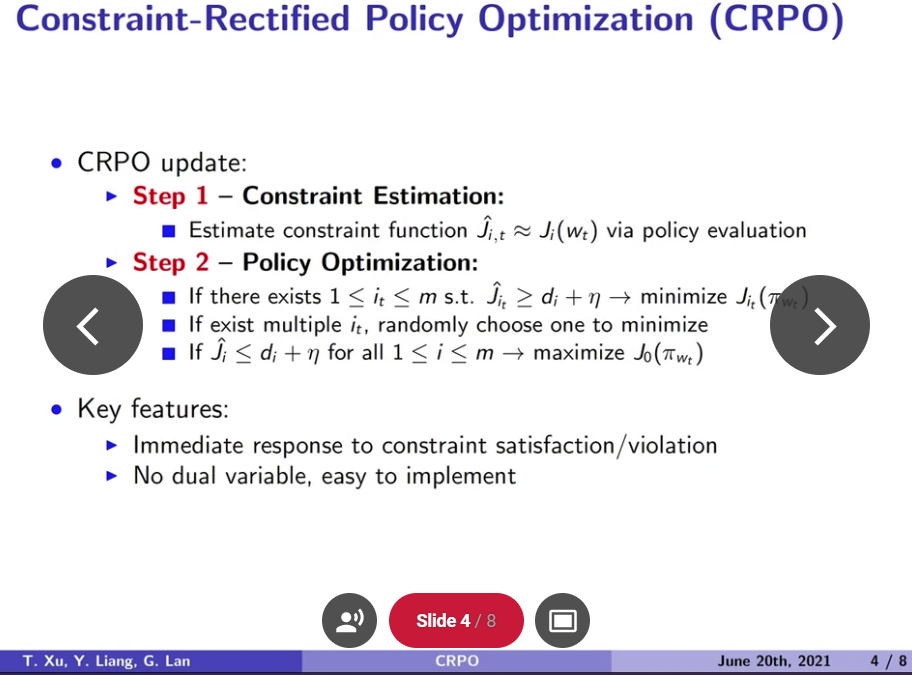

CRPO 2021 ICML

CRPO slideslive

CRPO slideslive 短

CUP 2022 NIPS

强化学习 safe RL小综述 从TRPO出发 捋清CPO | CUP编辑于 2022-11-24

将GAE引入推导,得出了更紧的上下界

在具体的实现上做了改变,使得每次更新对计算资源的需求更小。