global vectors for word representation

B站学习视频

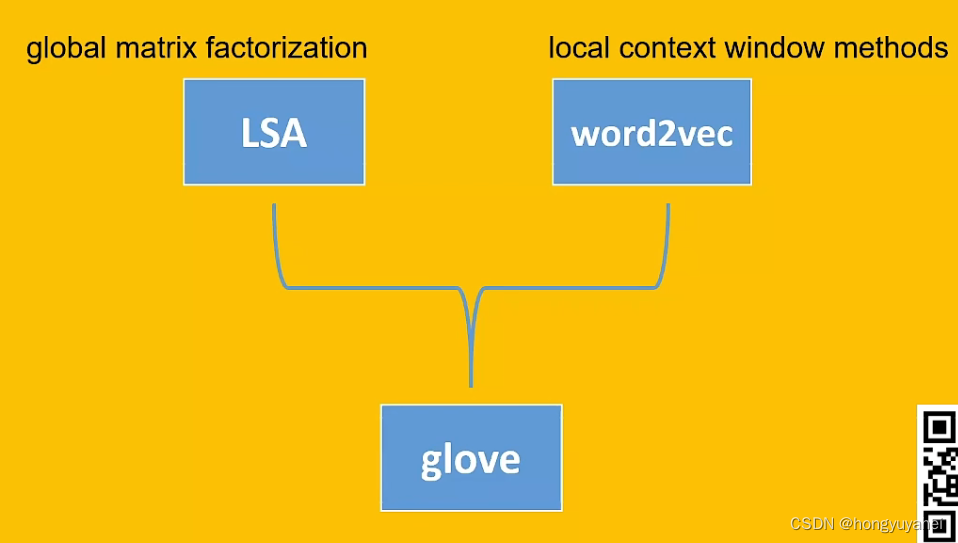

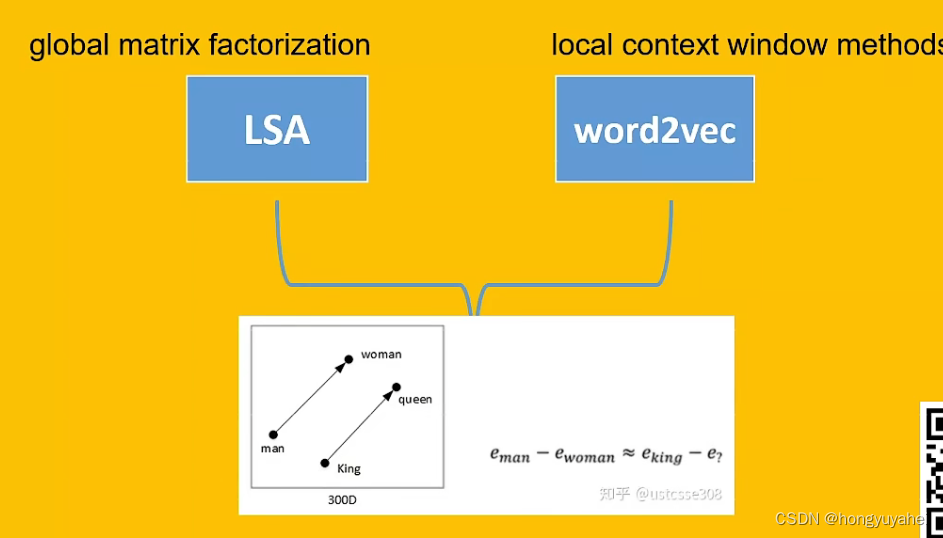

1、LSA与word2vec

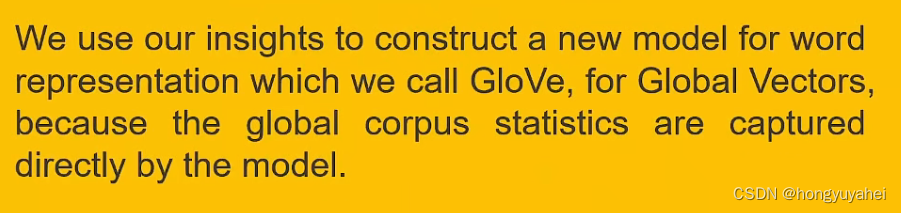

我们用我们的见解,构建一个新的模型,Glove,全局向量的词表示,因为这个模型捕捉到全局预料的统计信息。

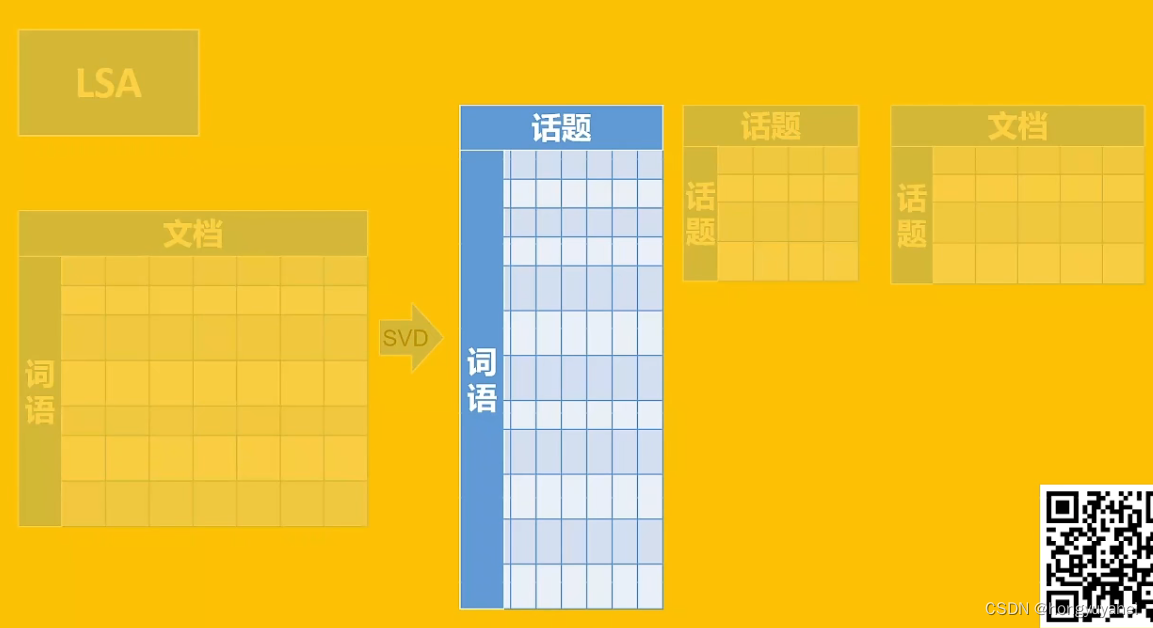

- LSA:全局矩阵分解

- word2vec:局部上下文窗口(词语类比)

LSA构建的是词语与文档的共现矩阵。

- SVD:奇异值分解

2、Glove

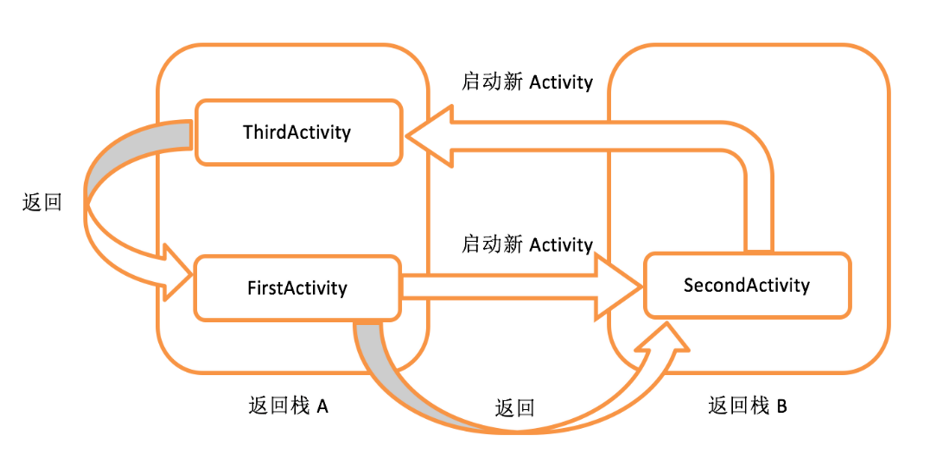

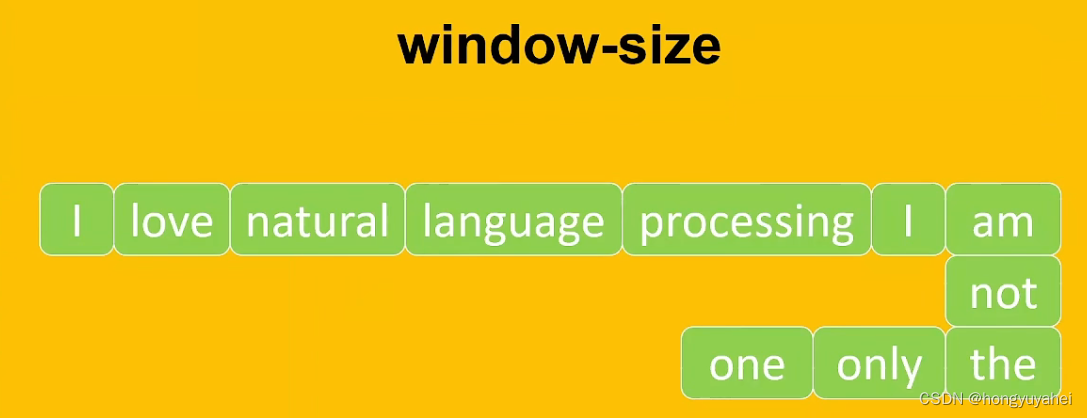

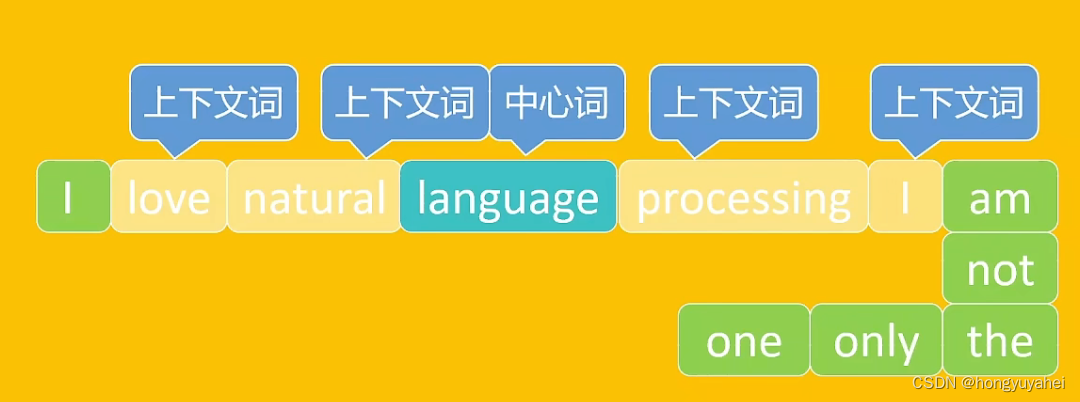

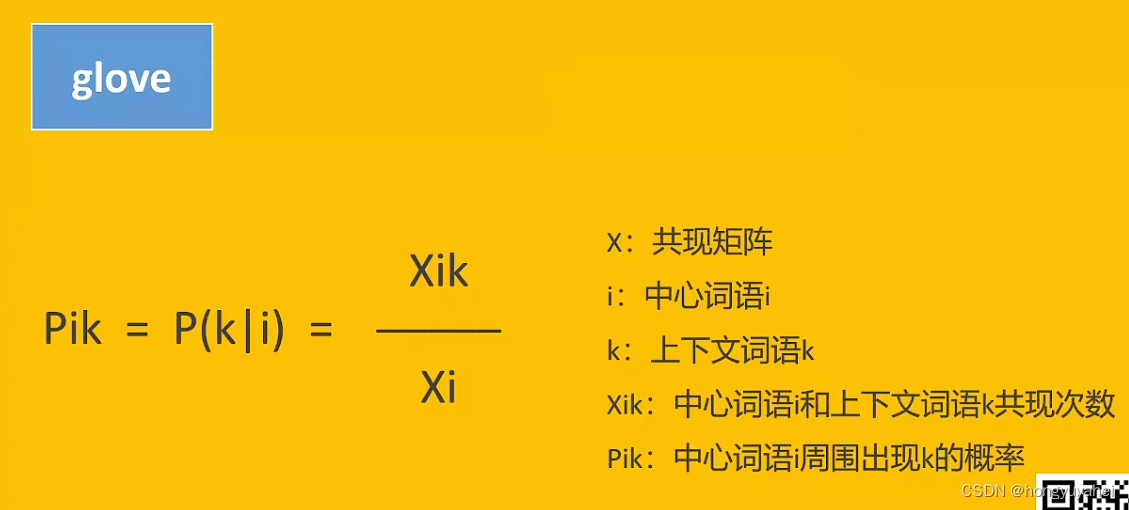

glove将词语分为中心词和上下文词,统计两者共同出现的次数。范围限制,窗口为1。

窗口大小为2,表示中心词前后大小为2的区域的词语才与中心词有共现关系,窗口之外的词语就不能称之为共现。

共现矩阵X为对称矩阵,共现次数和权重递减函数的乘积,从而达到距离越远的共现词对权重小,距离越近的共现词对权重大。

- Xi:中心词语i总共出现的次数

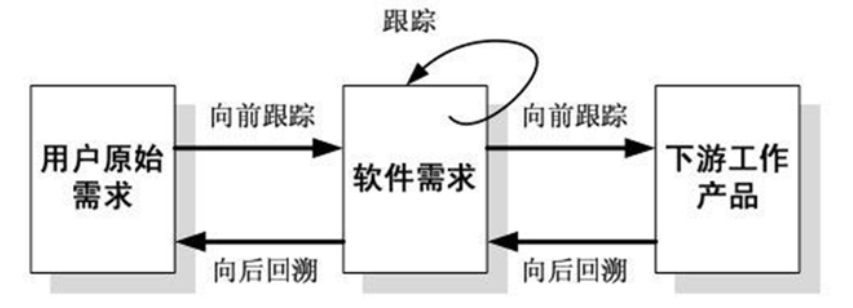

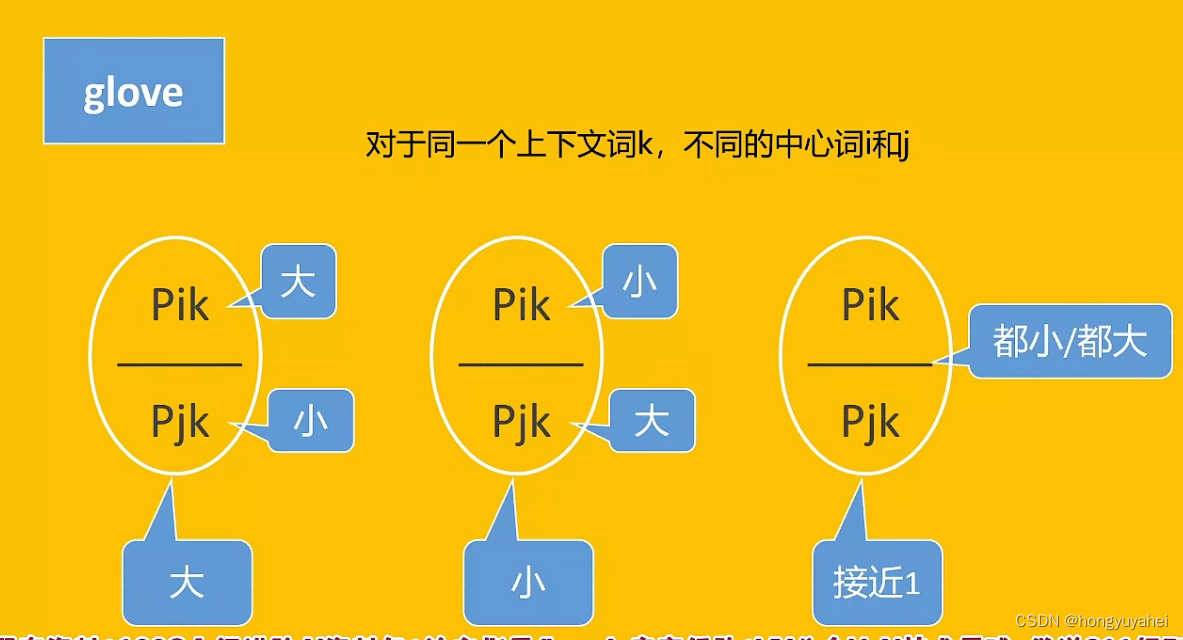

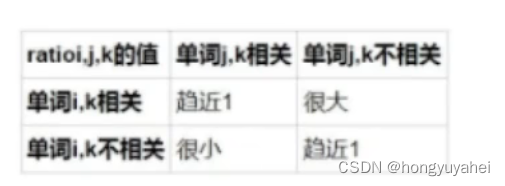

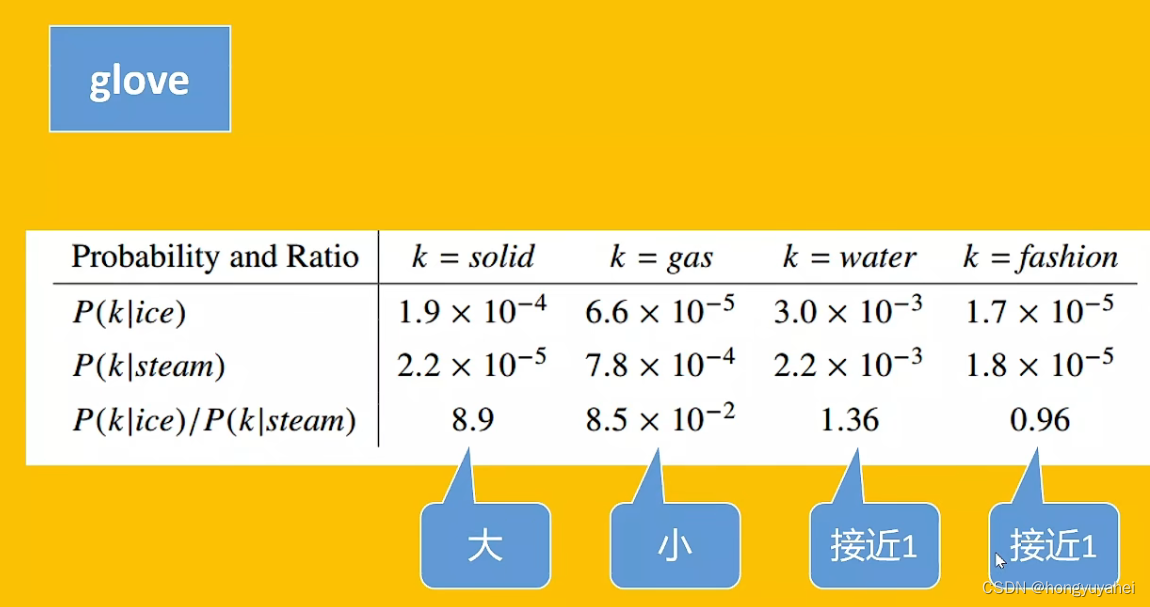

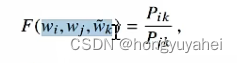

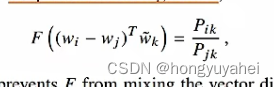

概率之间的比值更能捕捉词语之间的相关和不相关关系。

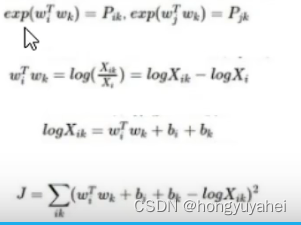

具体推导过程:

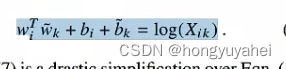

系列推导后得到最终方程:

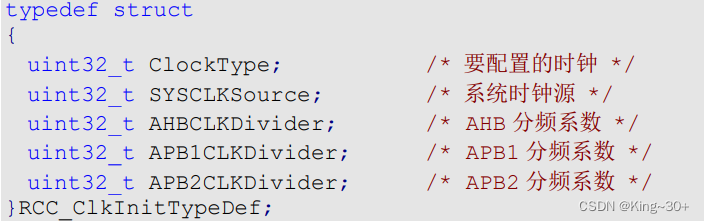

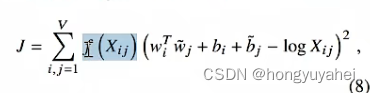

模型的代价(损失)函数:

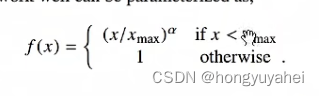

权重函数:

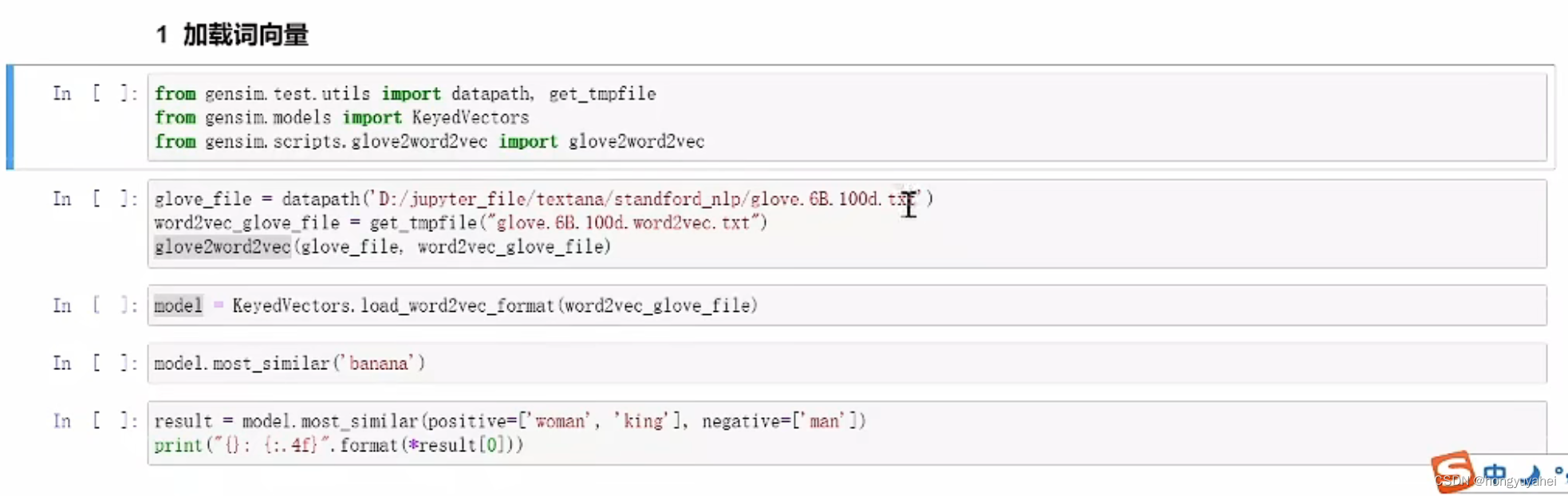

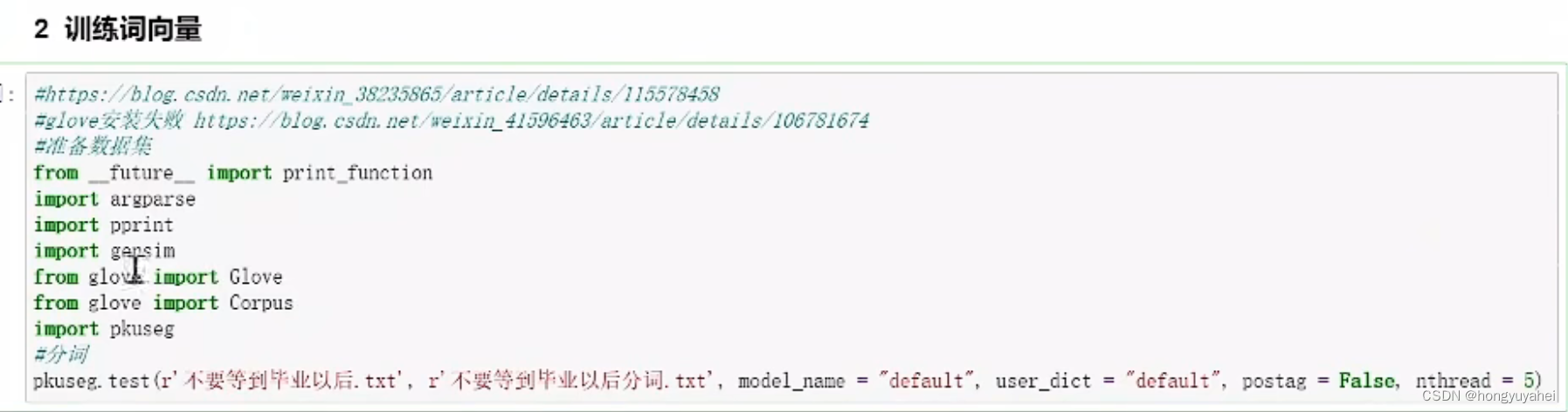

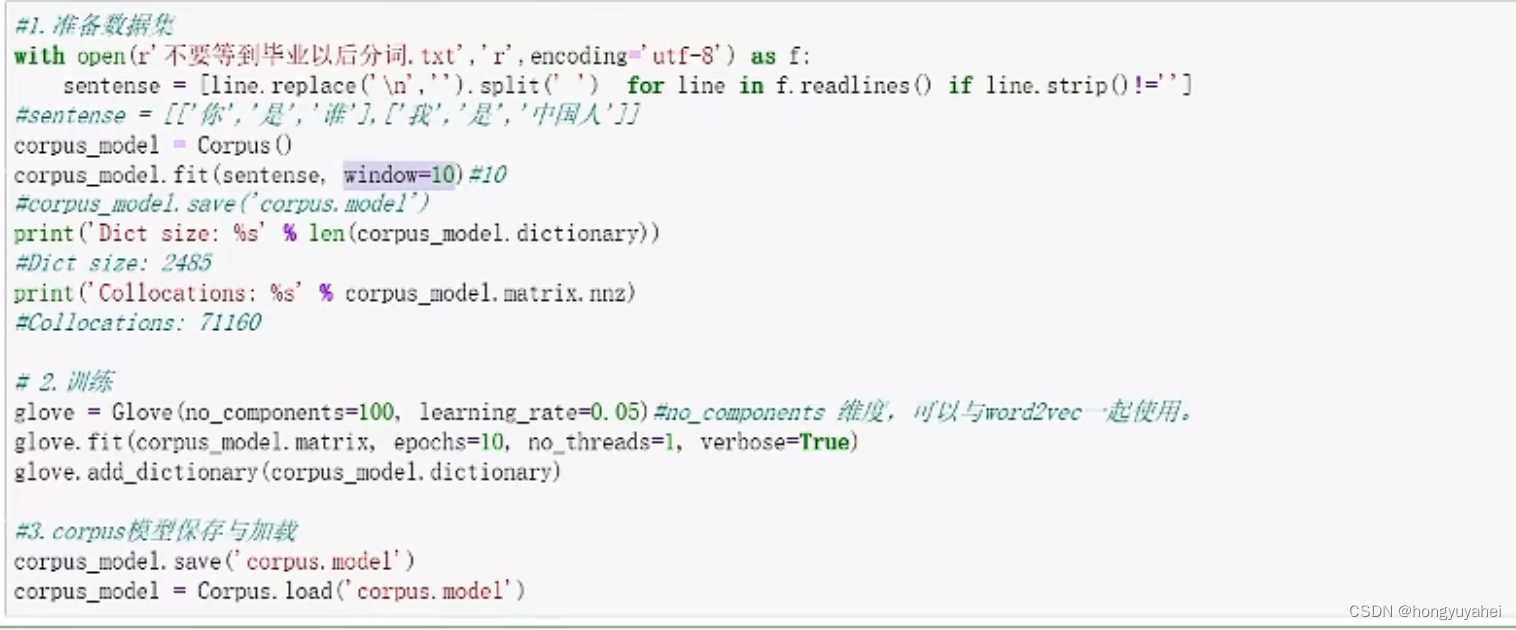

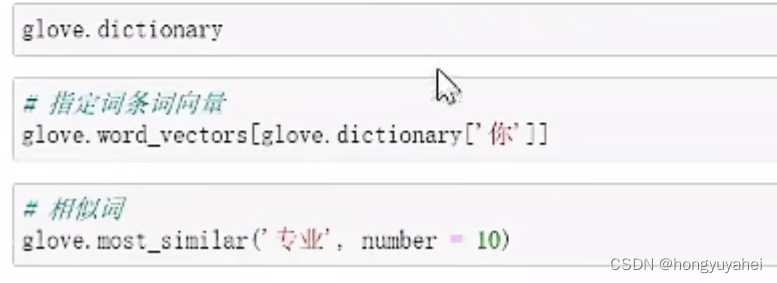

通过视频中的讲解主要了解共现矩阵及词向量损失函数推导过程及代码的使用!