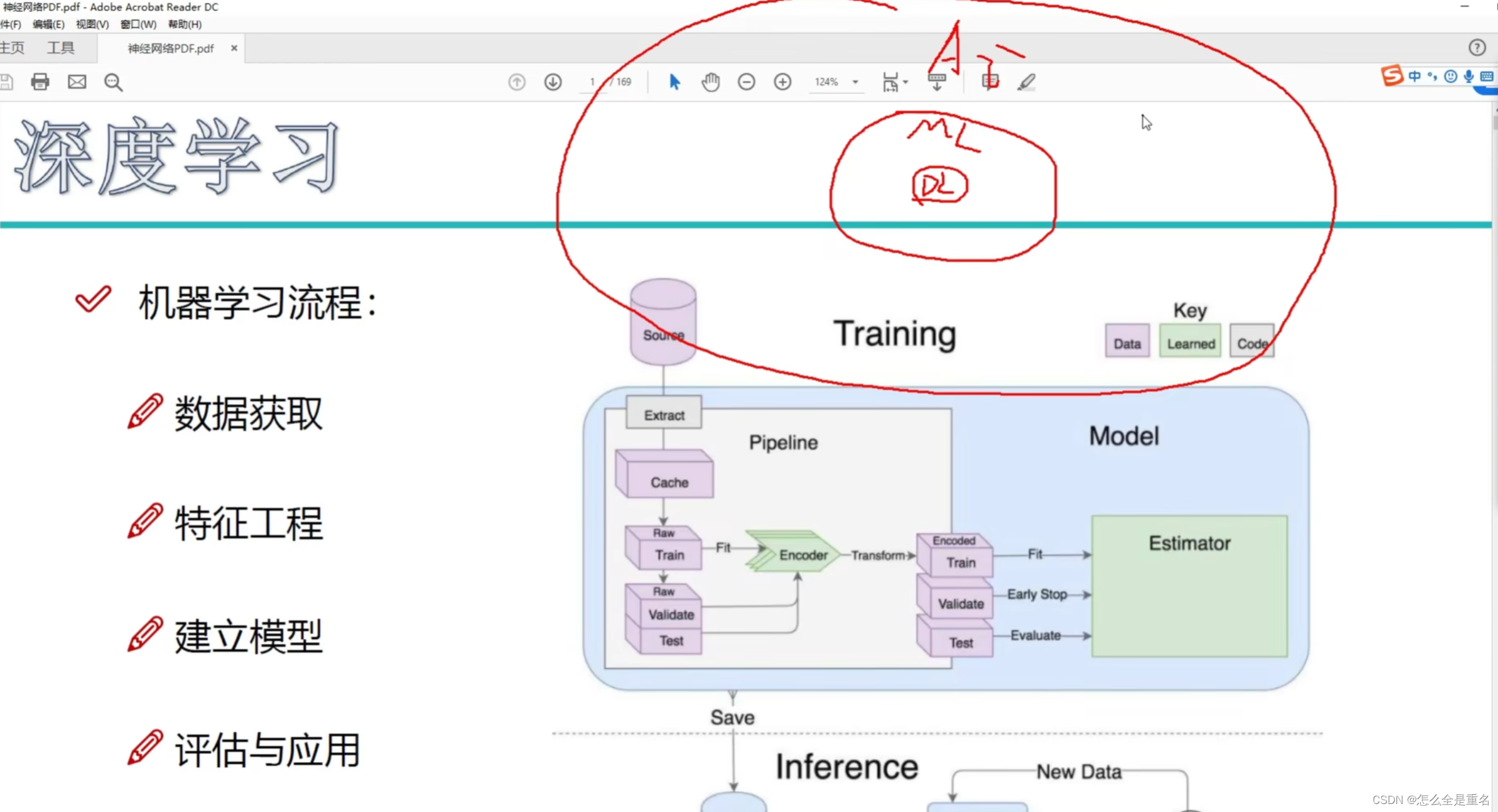

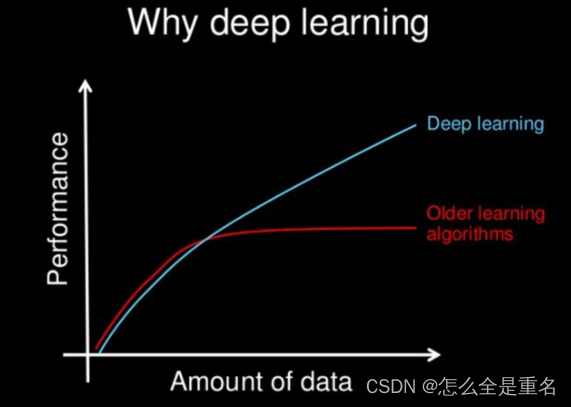

深度学习解决的问题

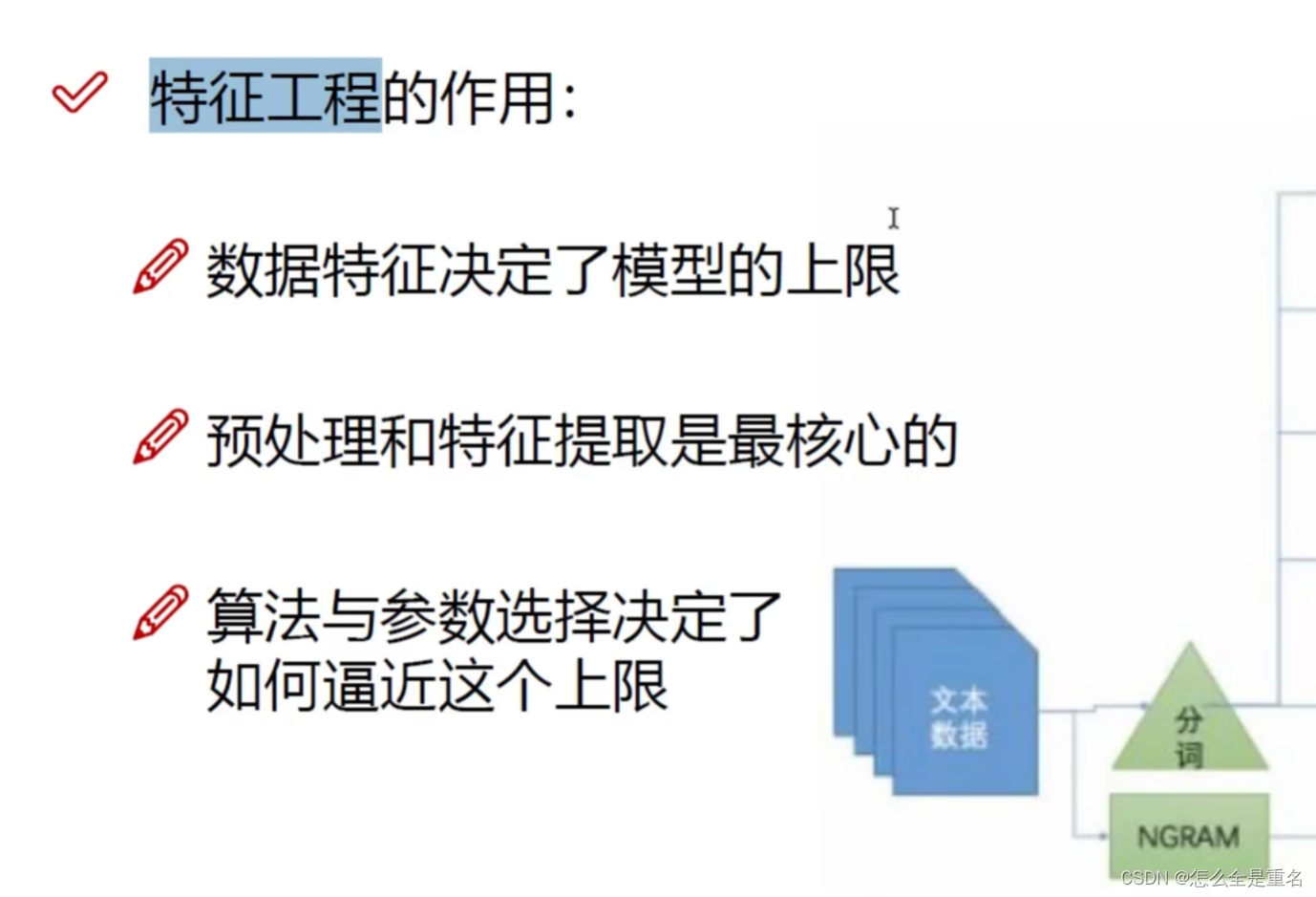

自动提取出最合适的特征

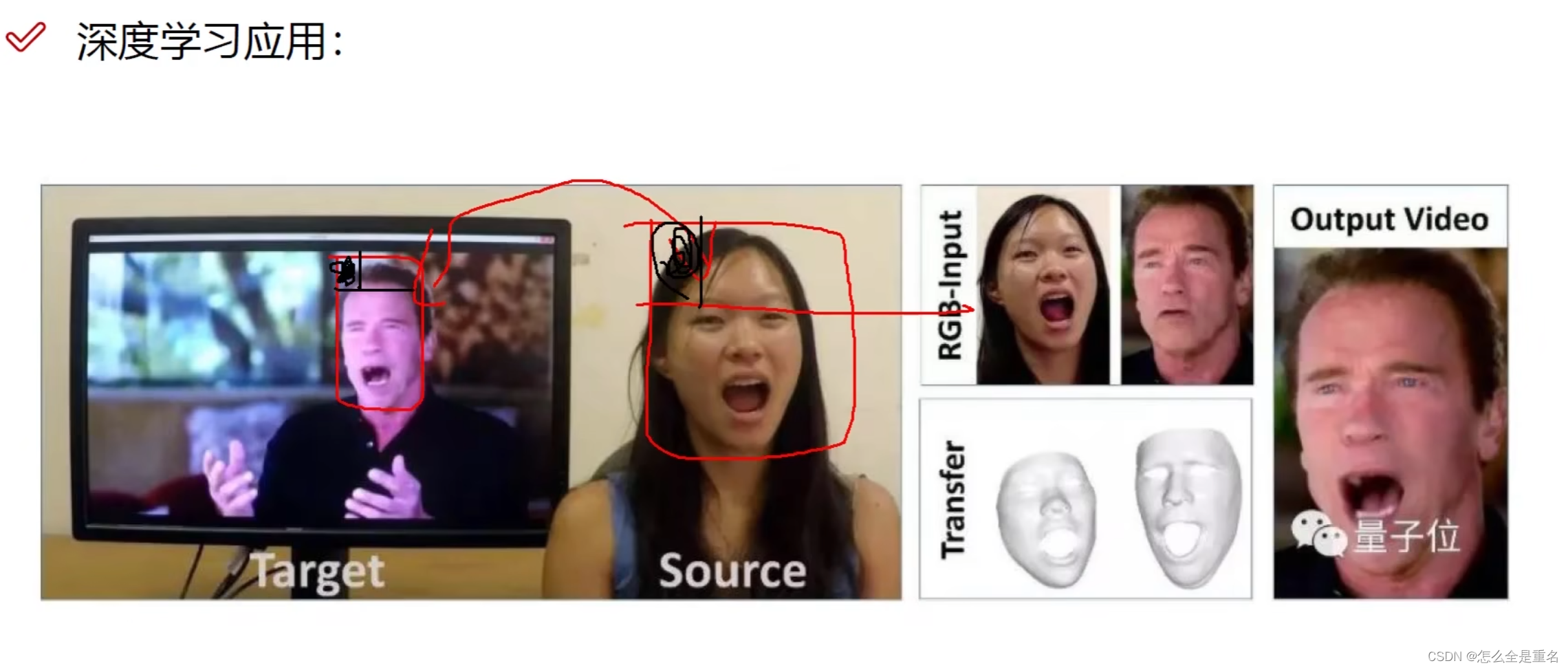

深度学习应用

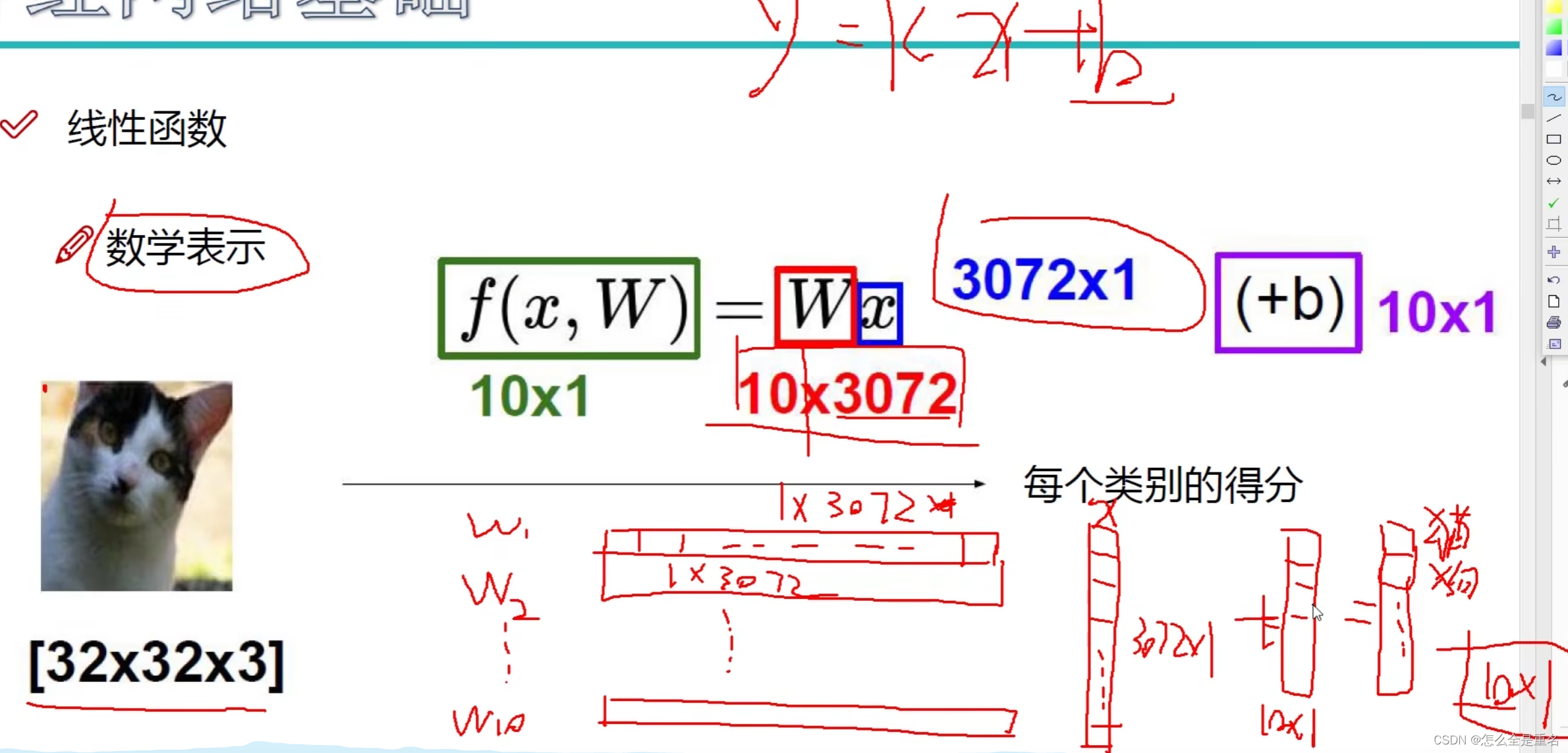

神经网络基础

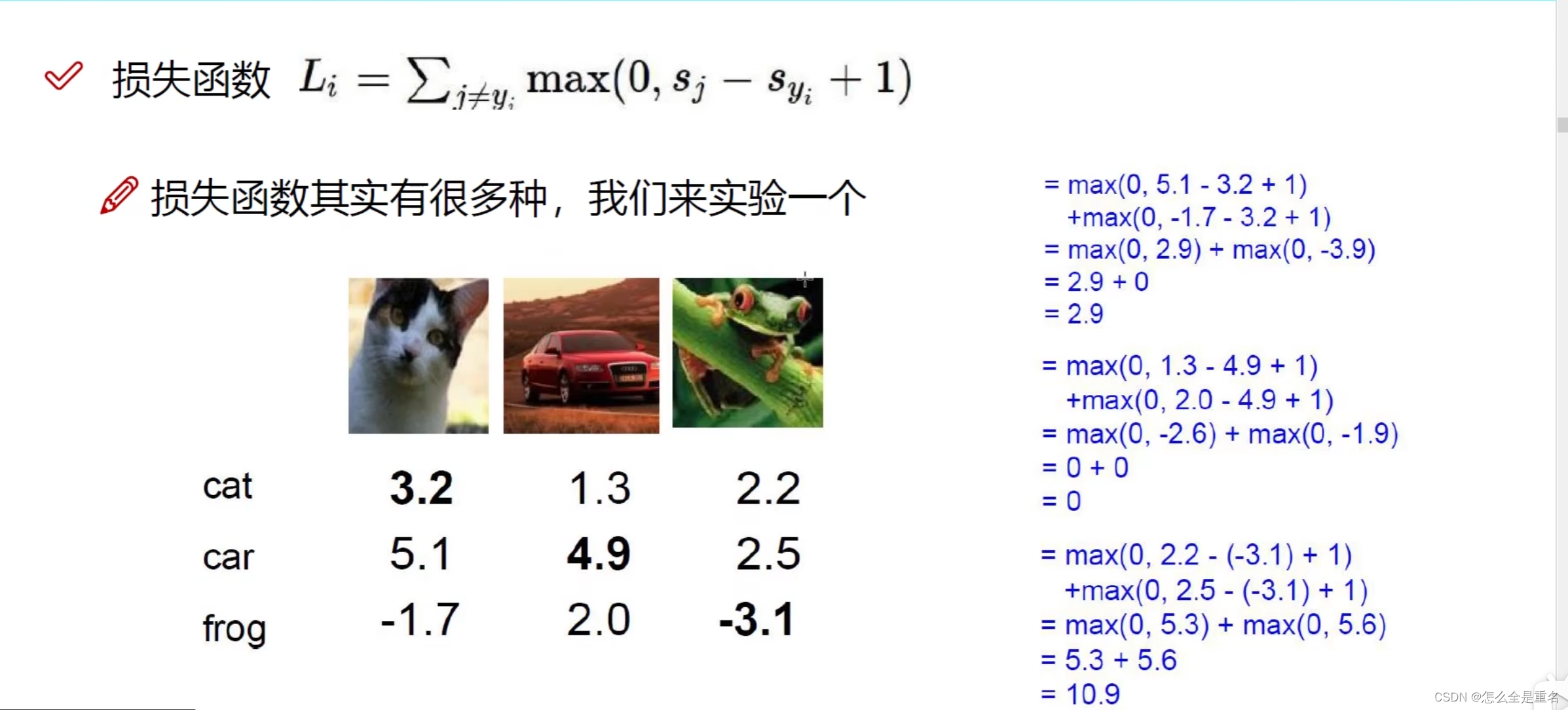

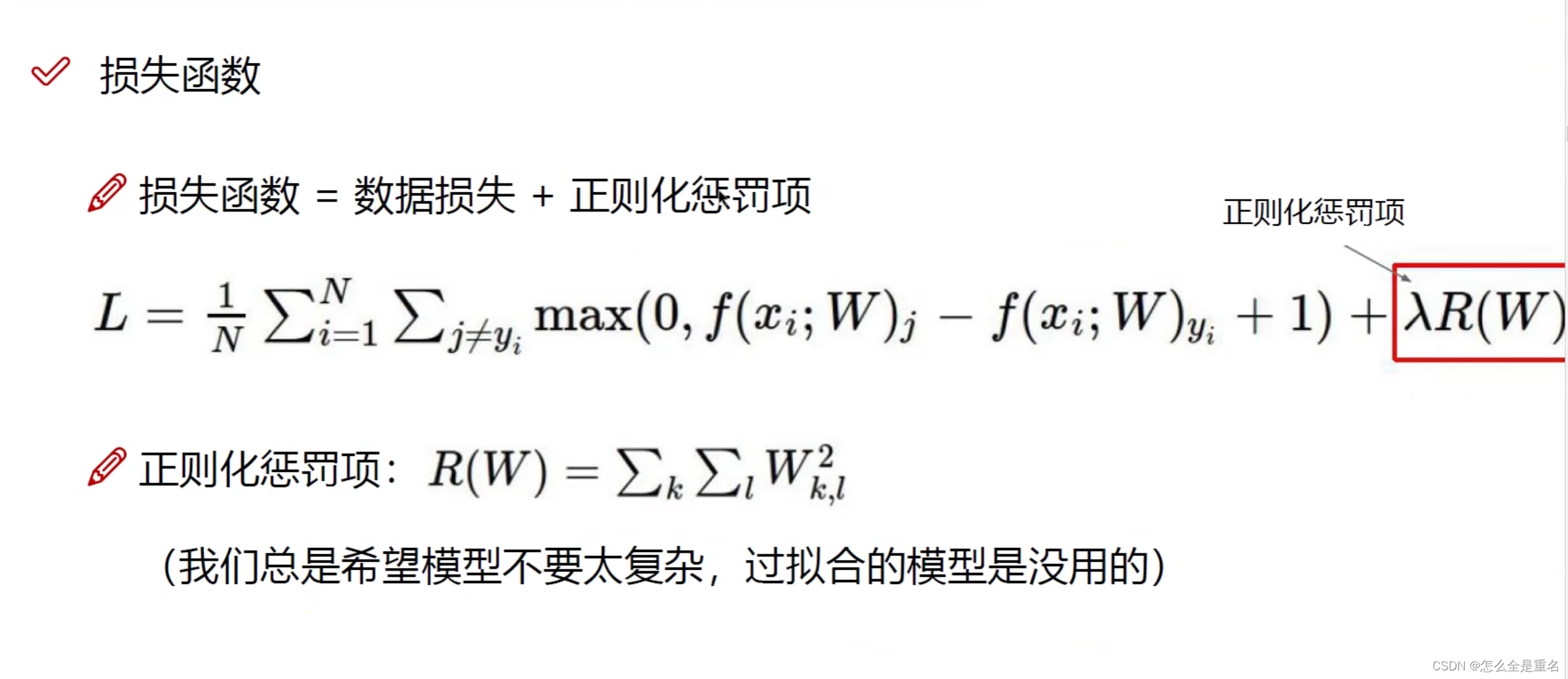

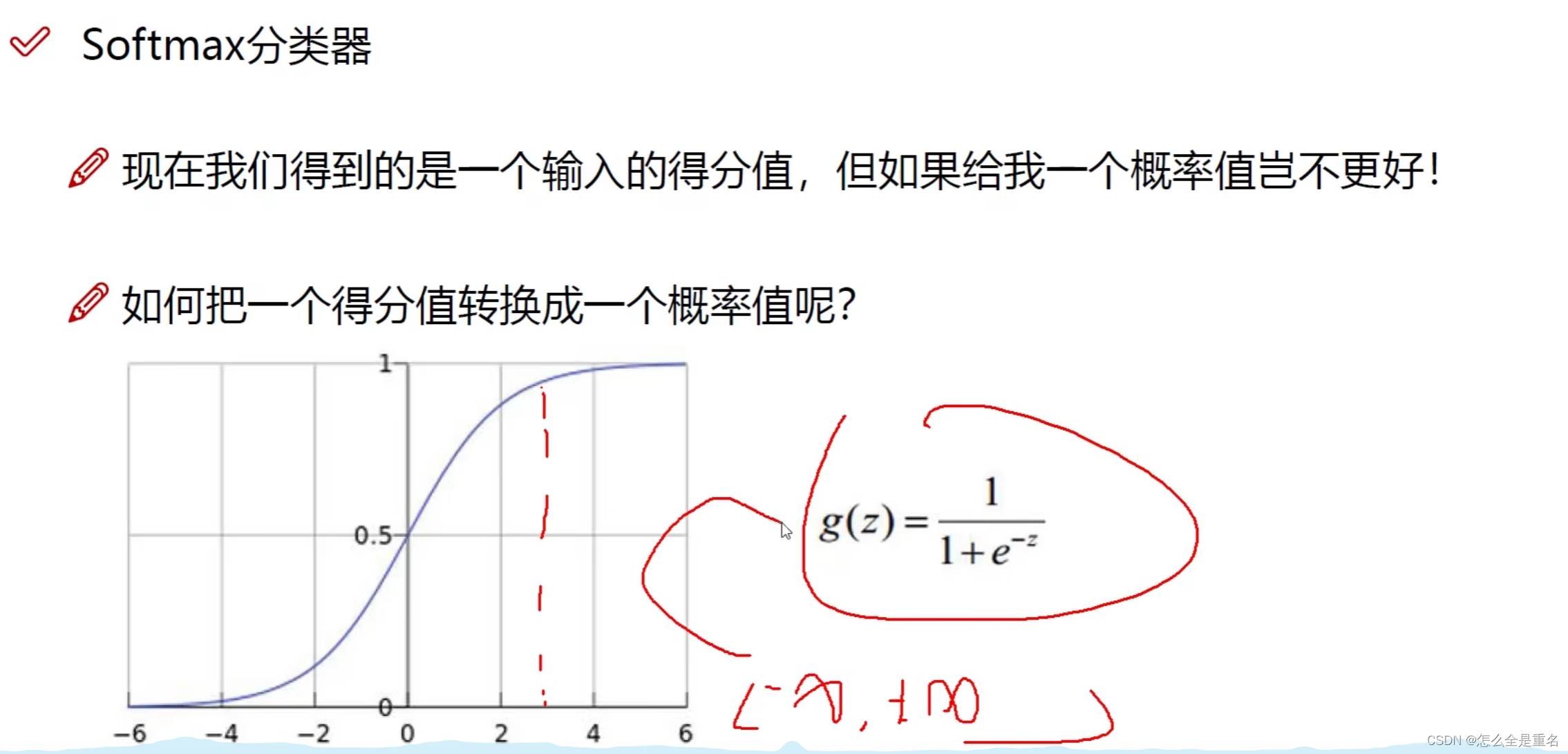

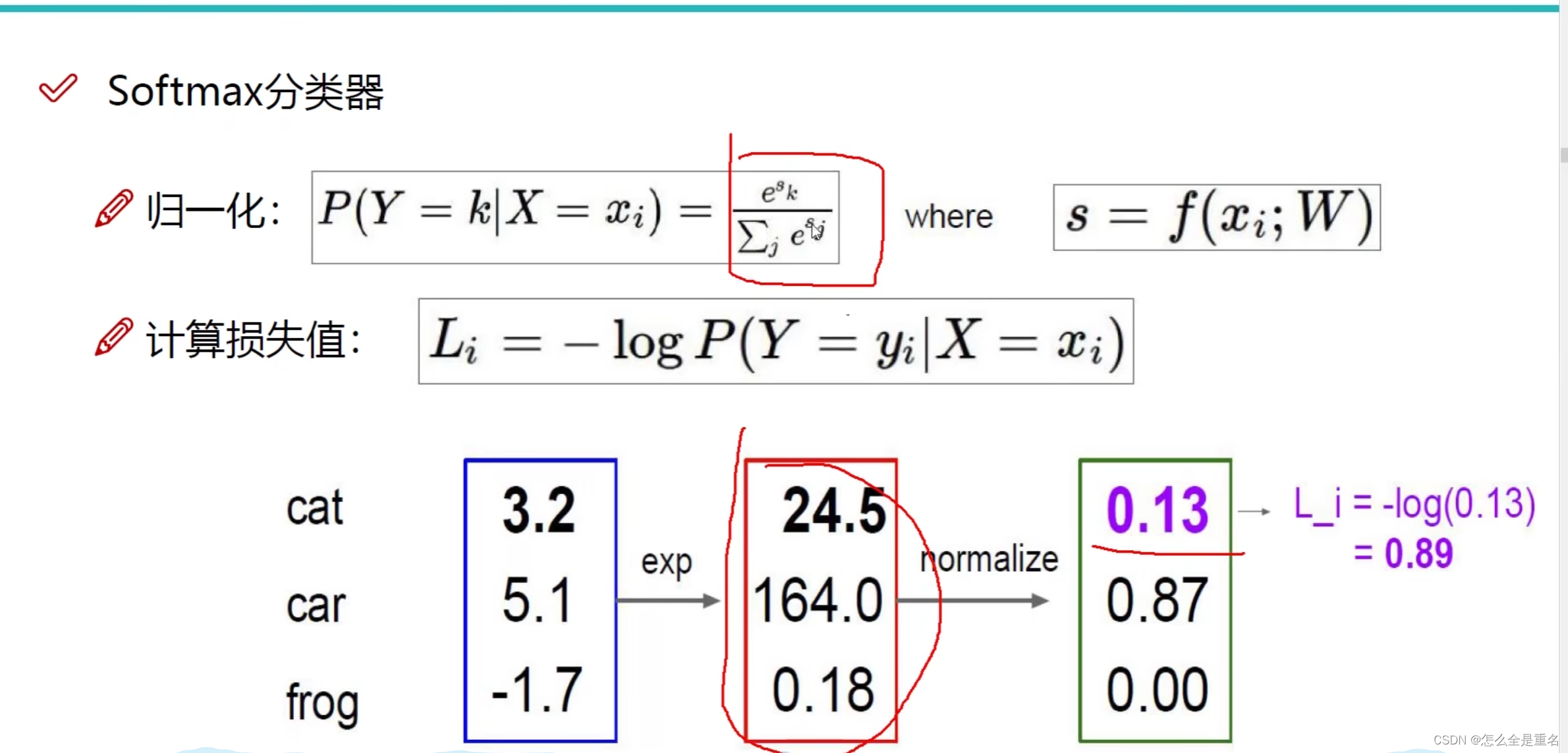

损失函数

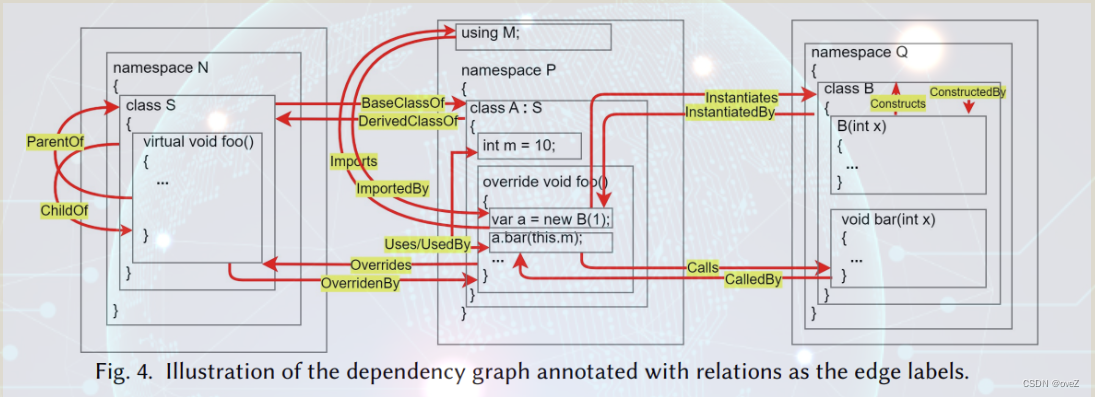

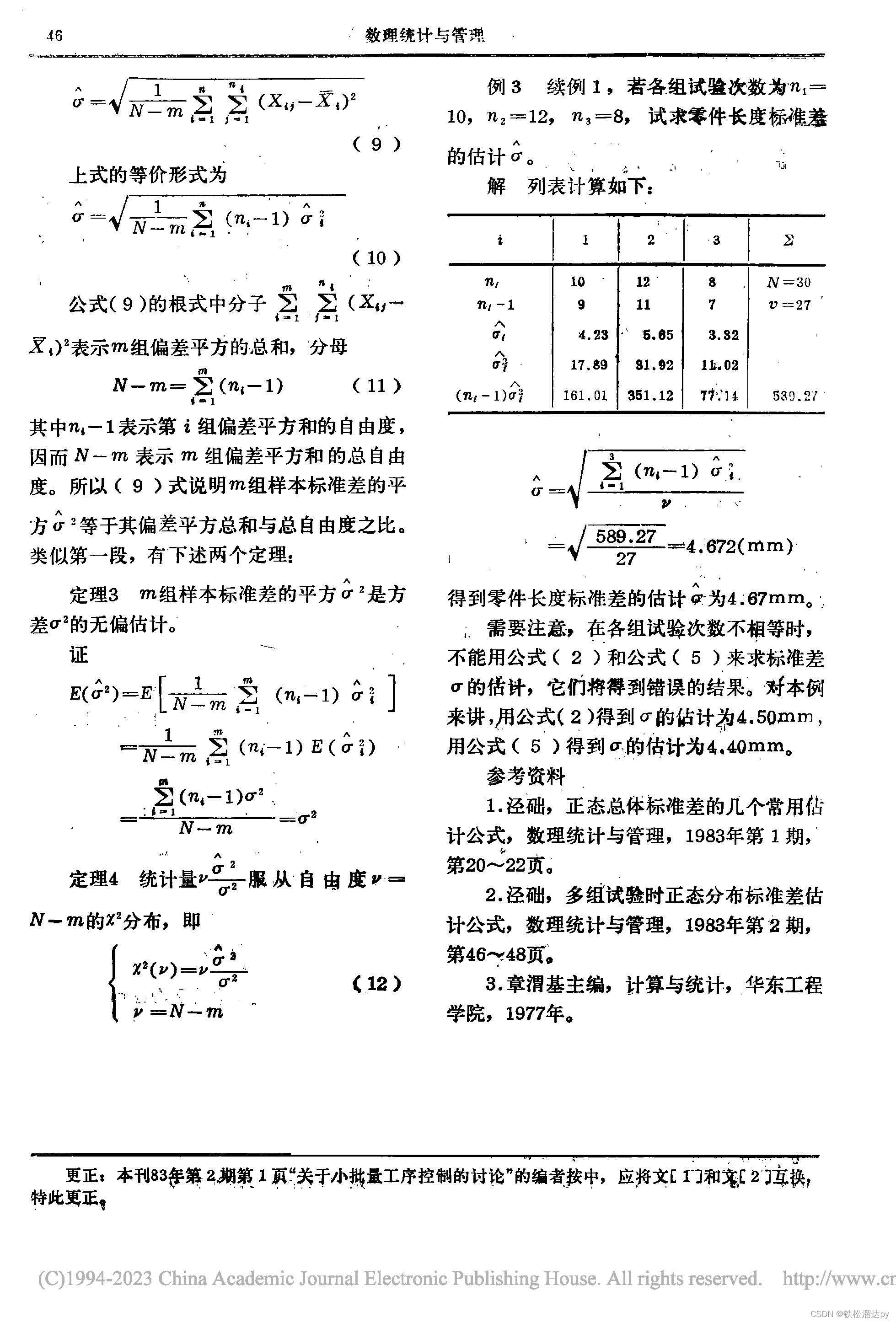

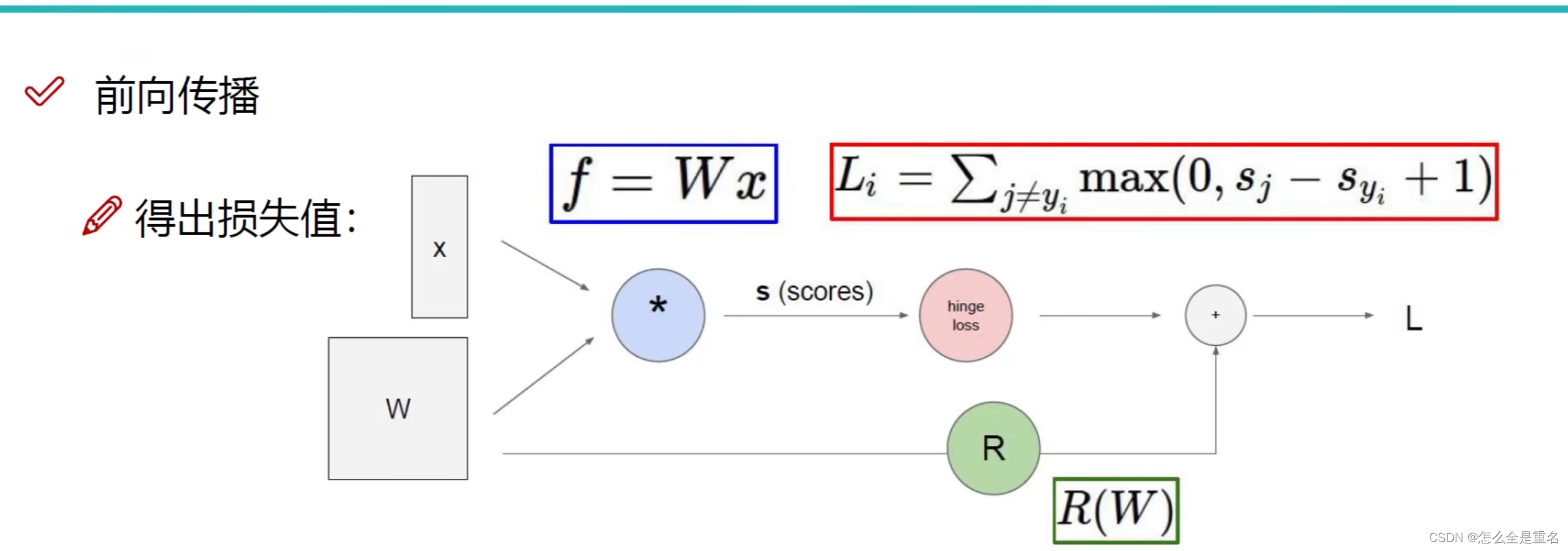

前向传播

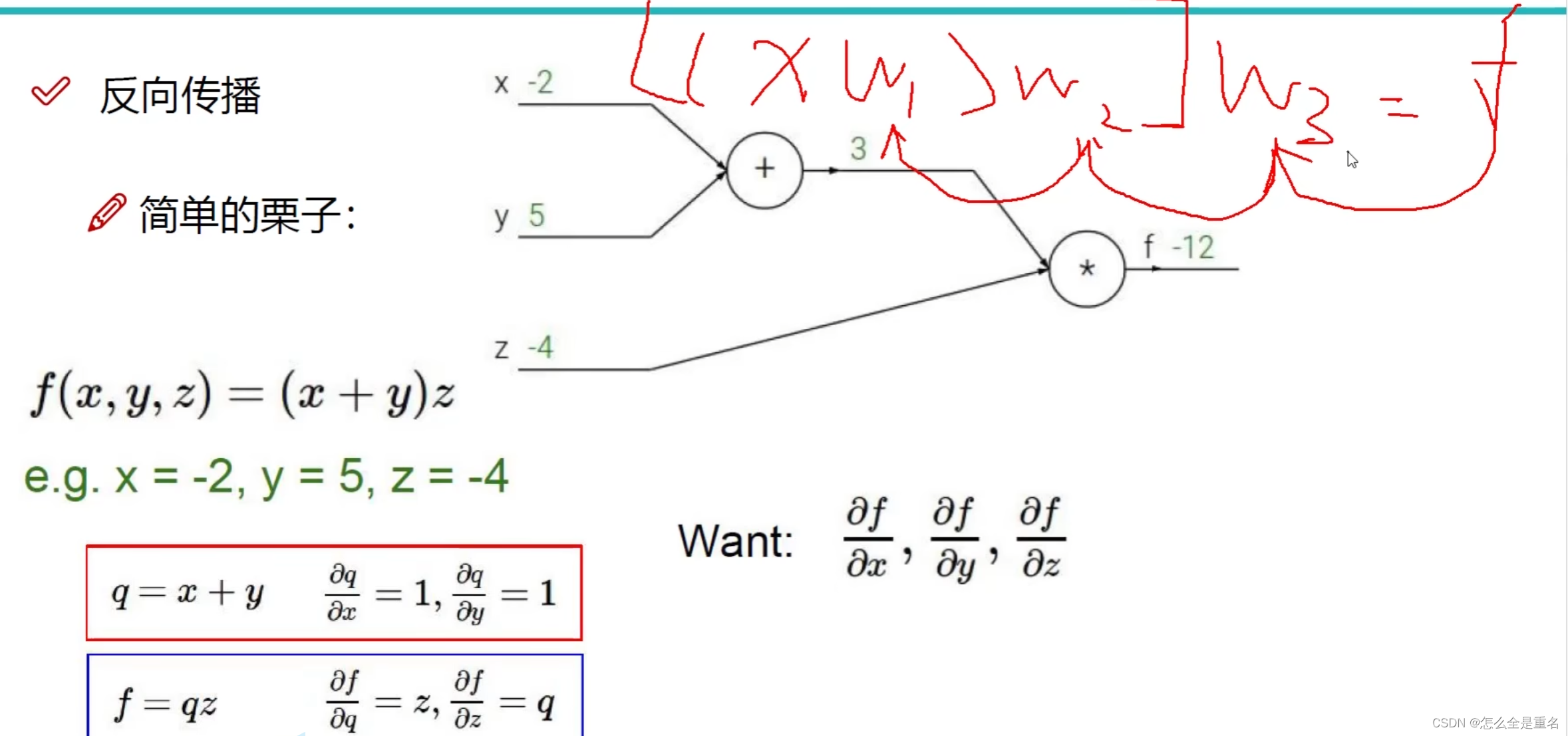

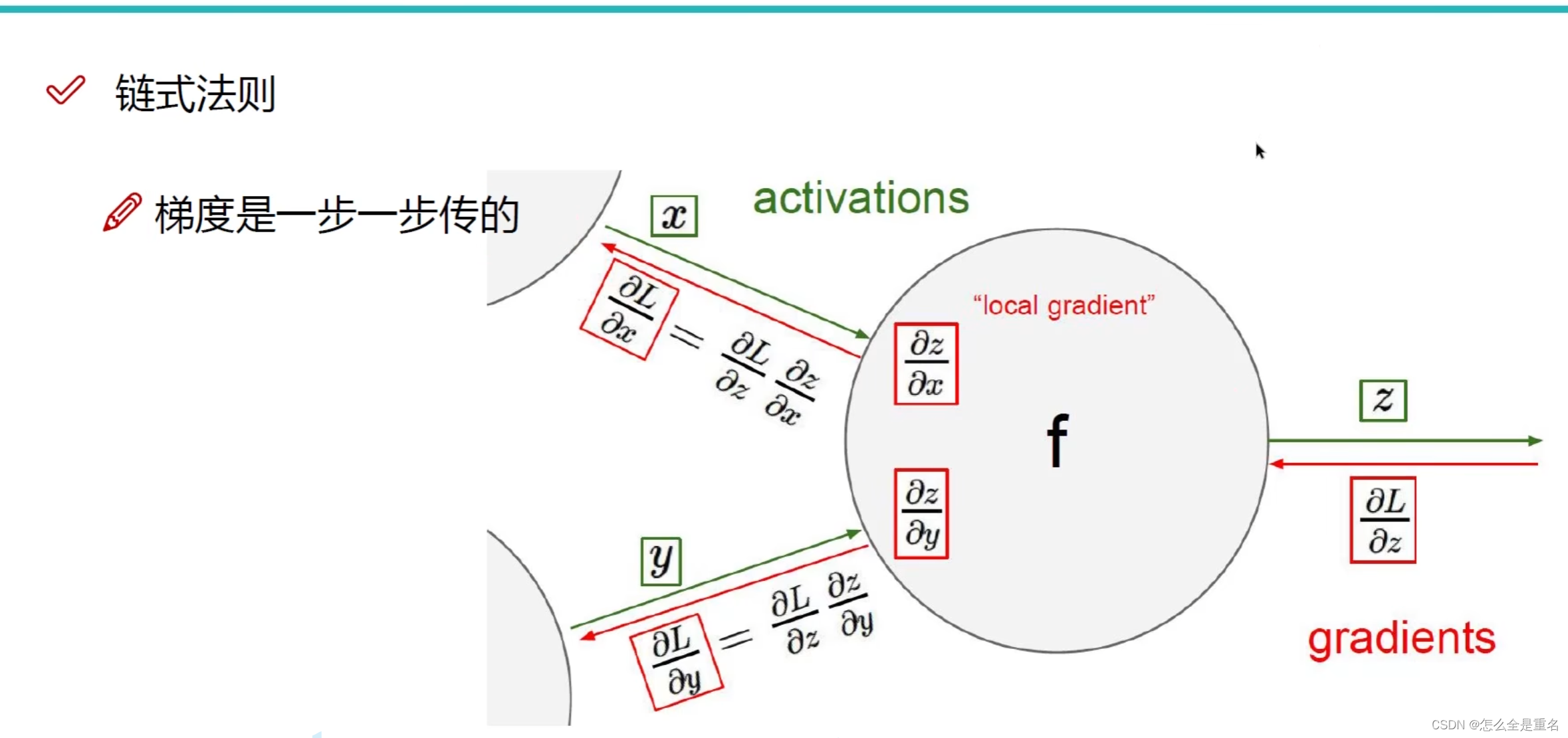

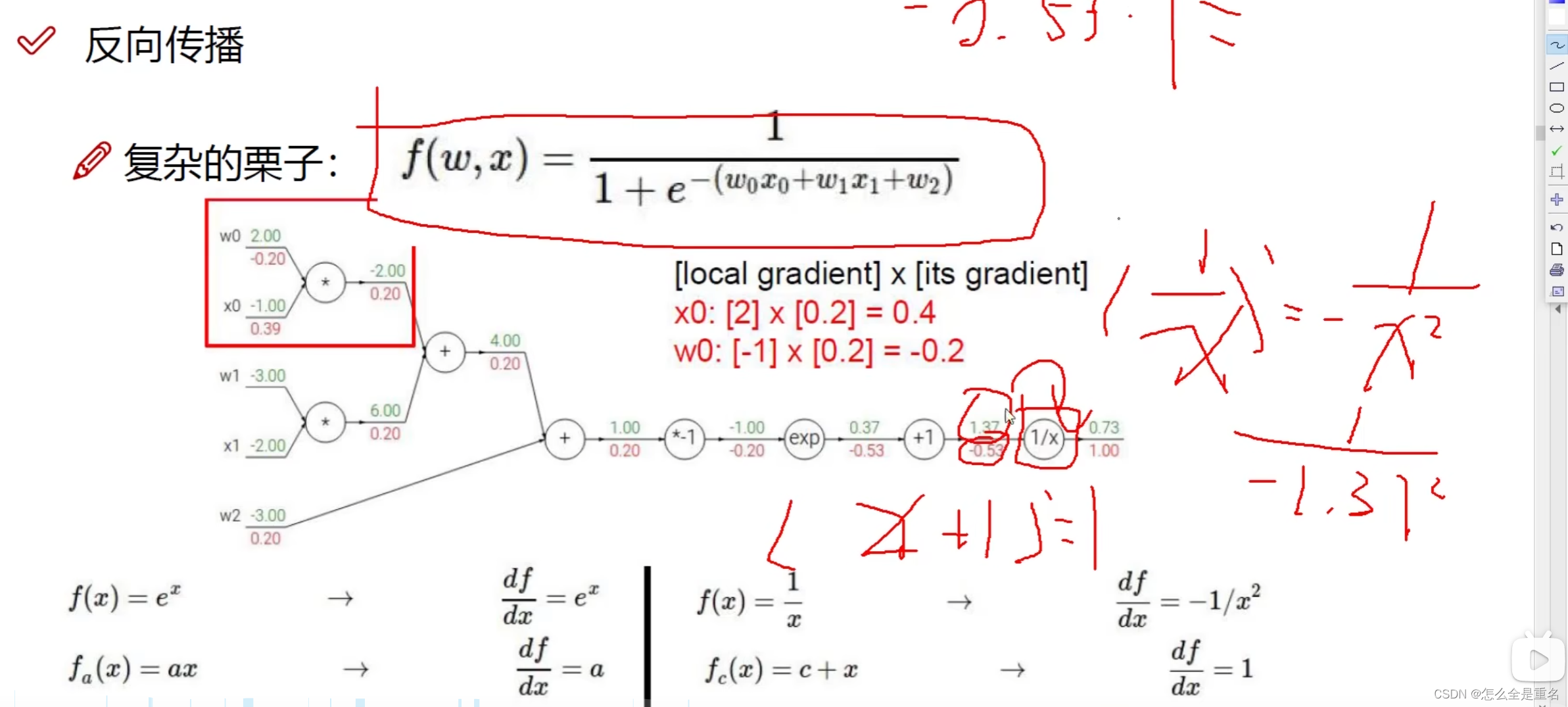

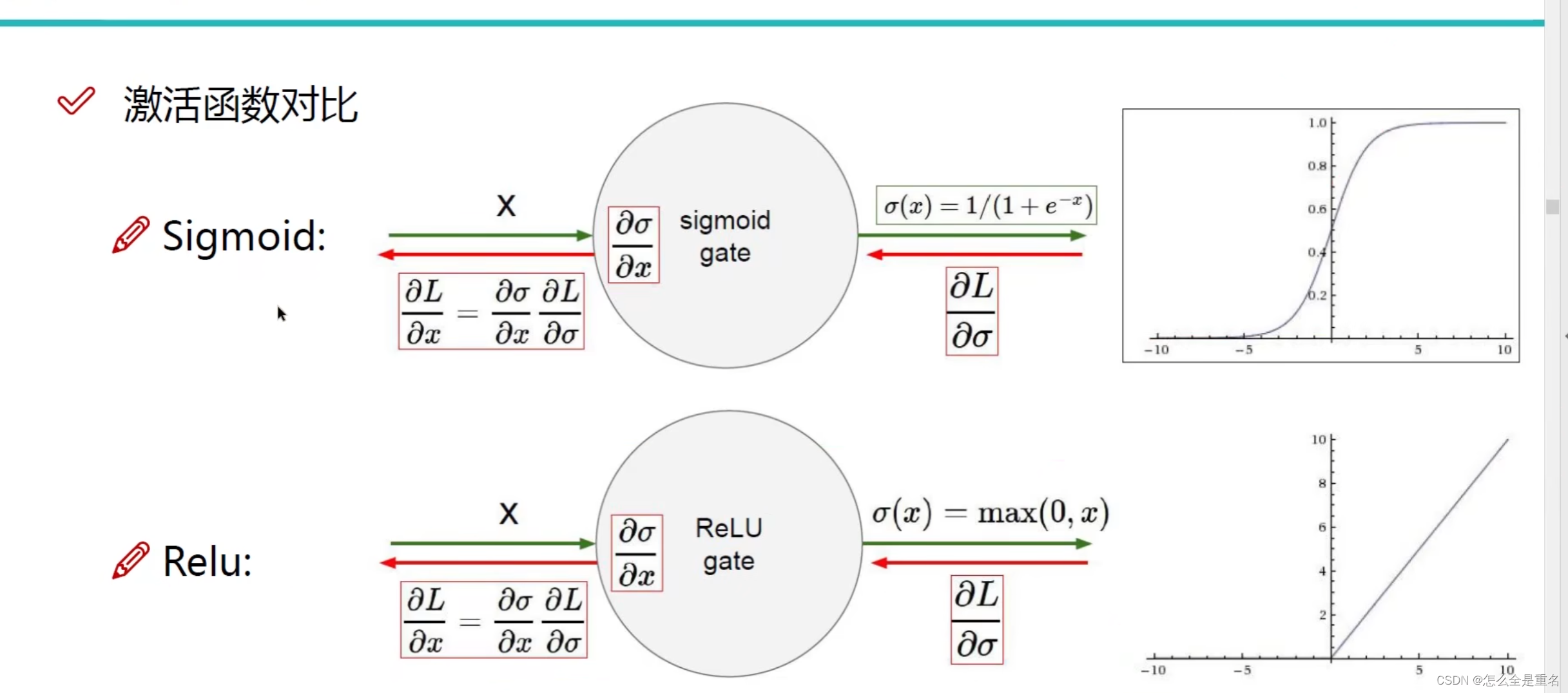

反向传播

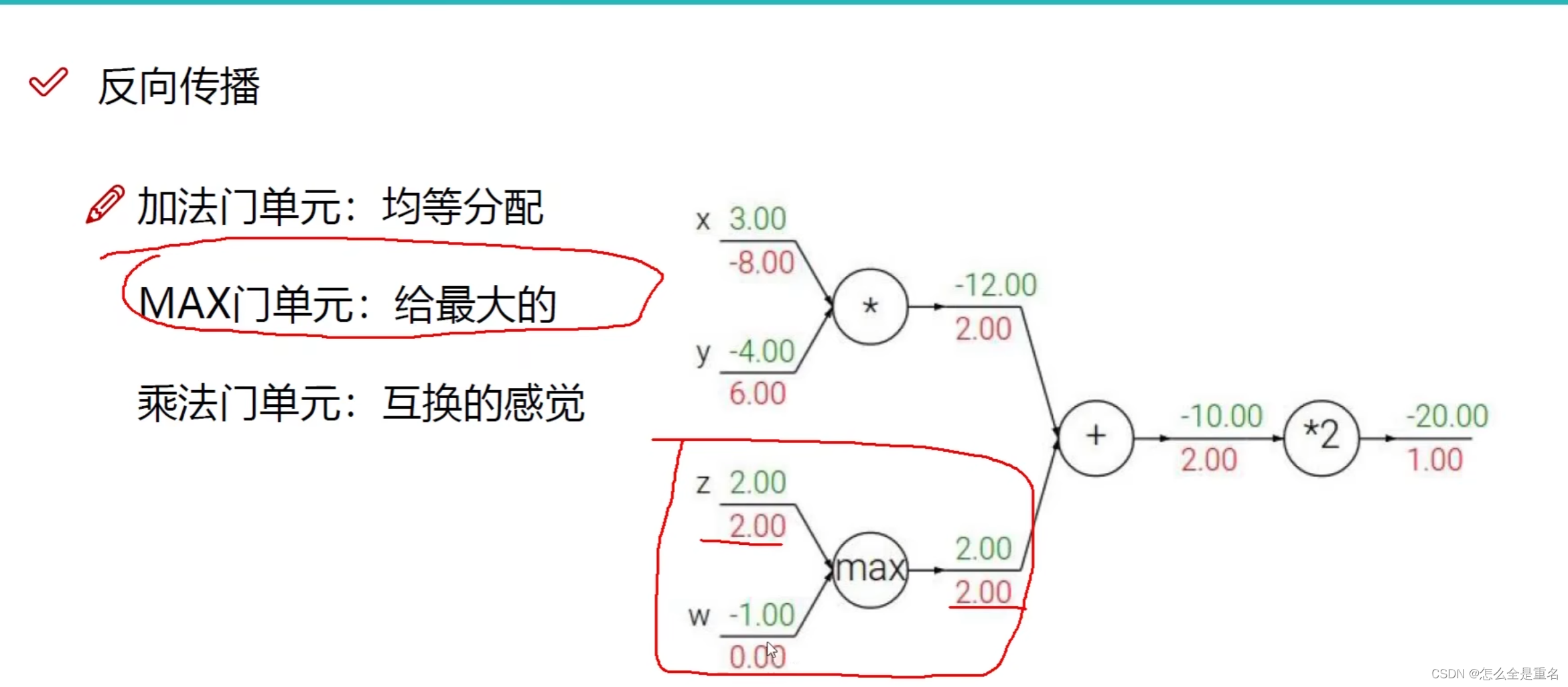

绿色字体为正向传播i输入,红色字体为反向传播梯度

MAX门单元只把梯度传给最大的

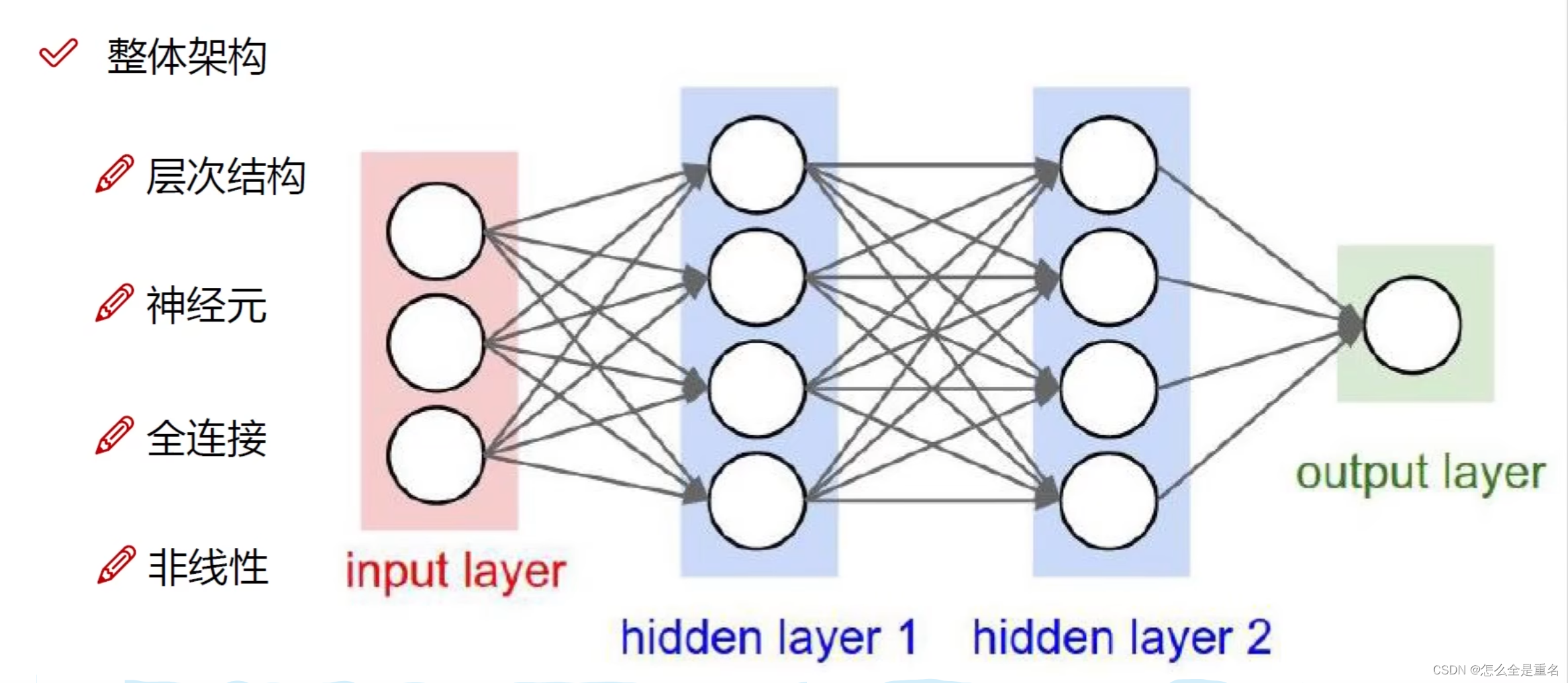

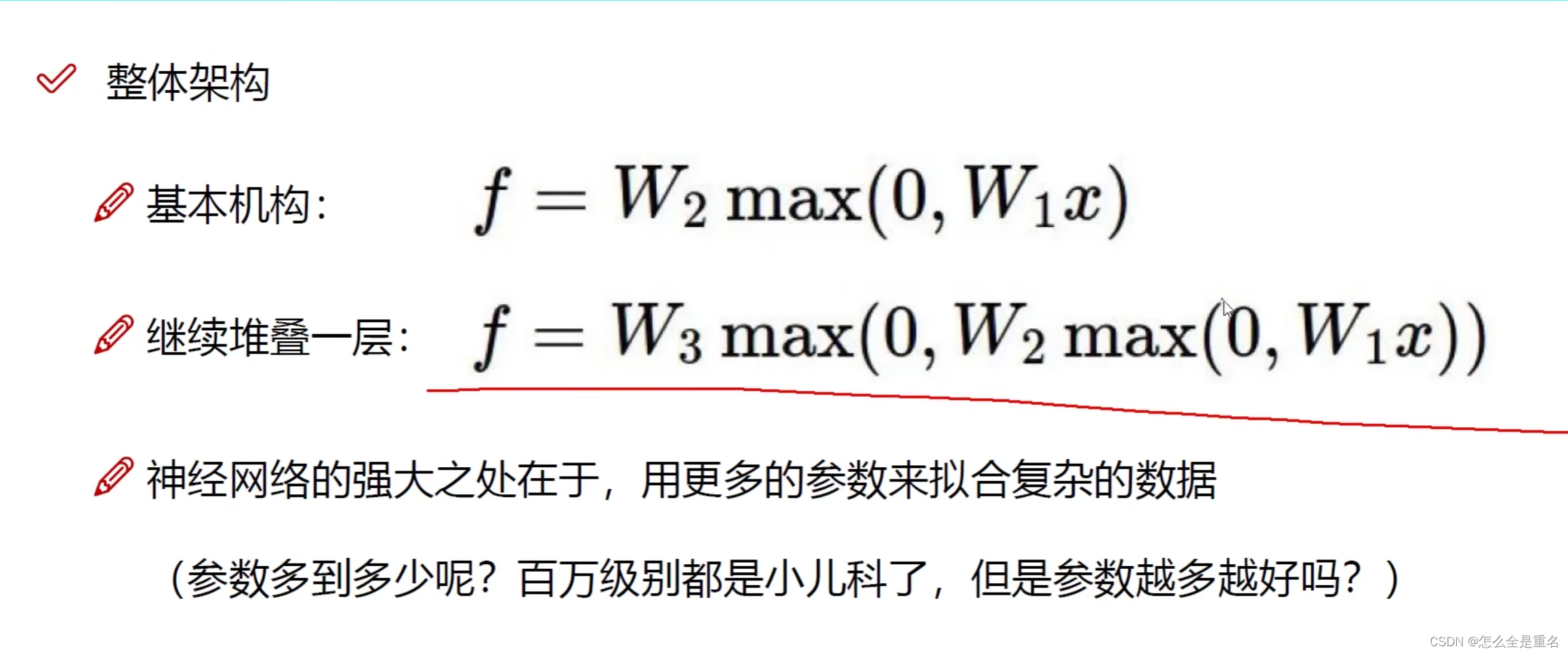

神经网络整体架构

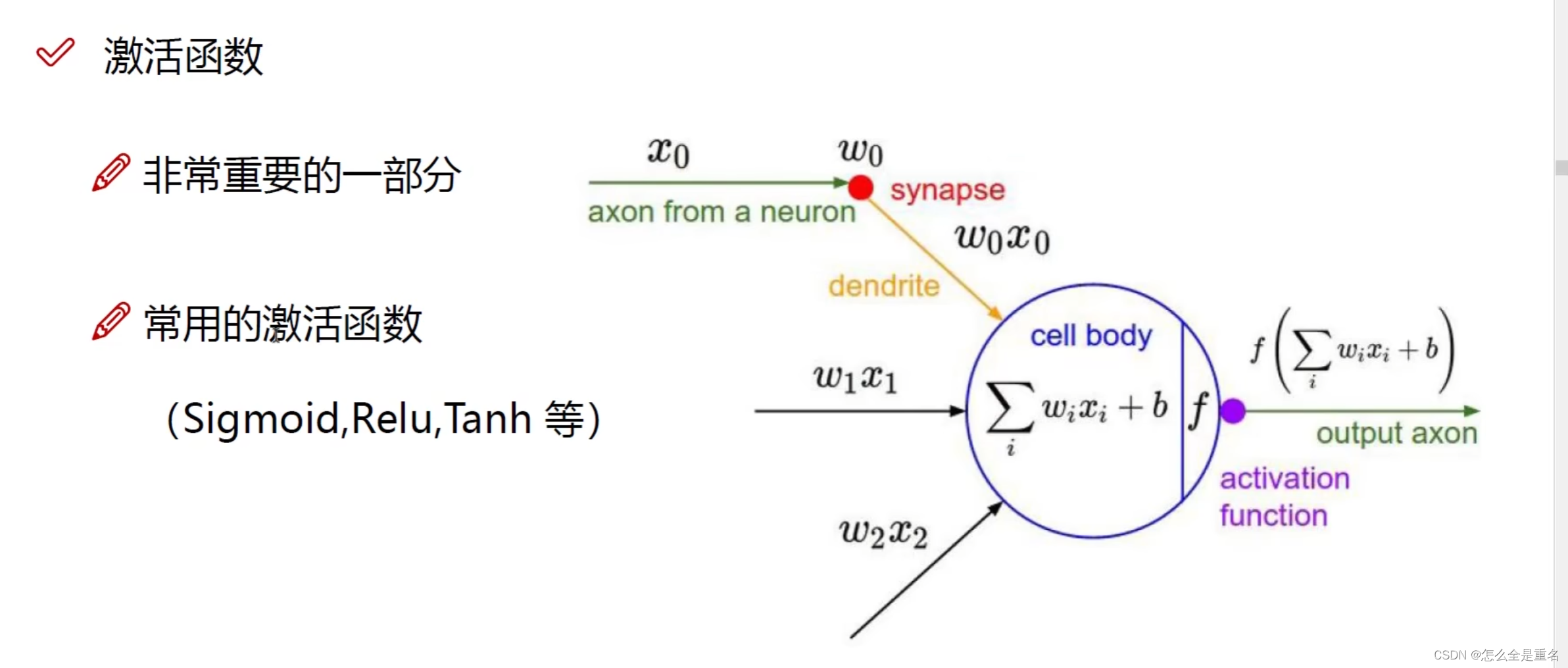

激活函数

隐藏层激活函数

一般选择Relu,sigmoid会出现梯度消失现象

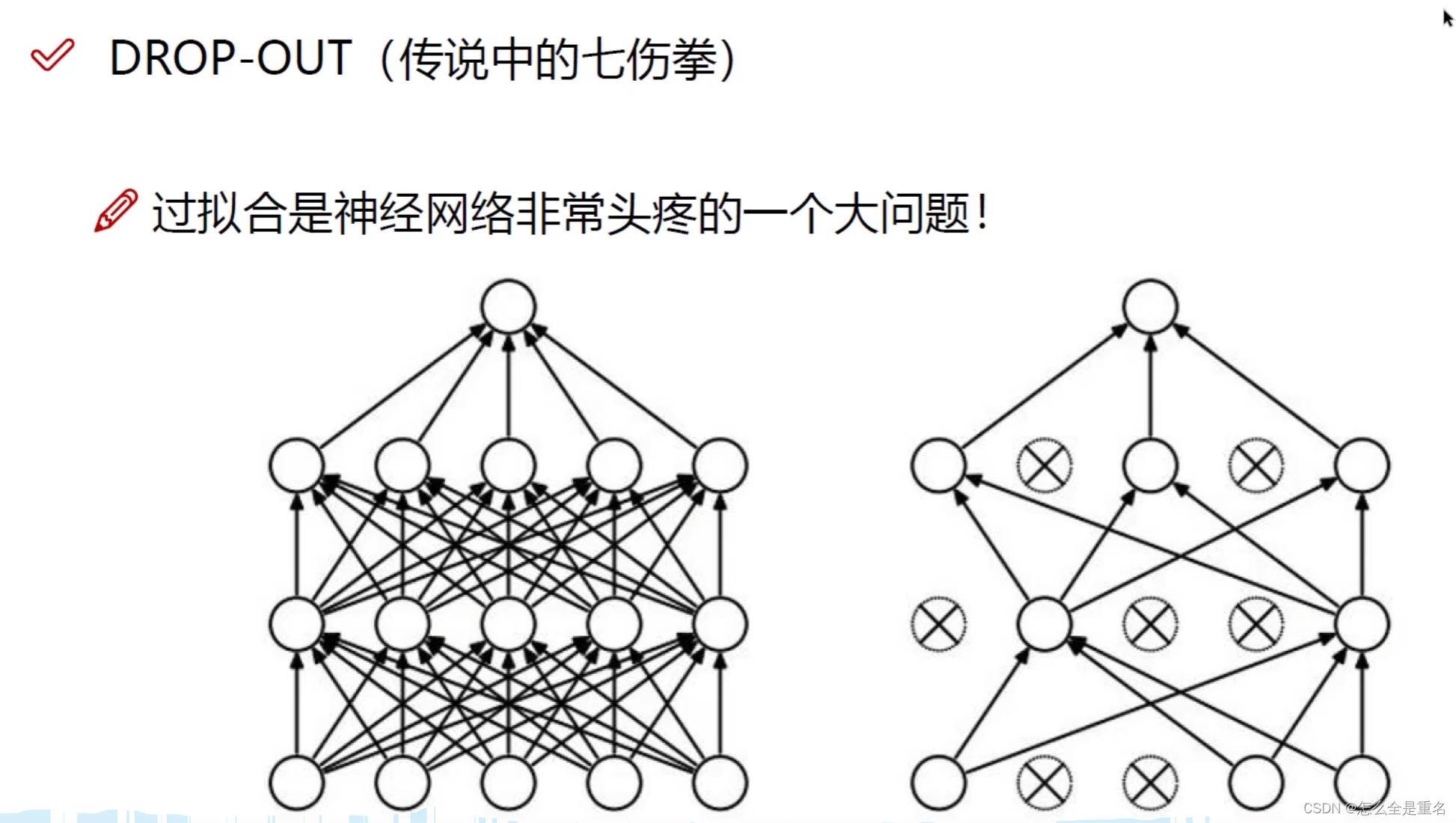

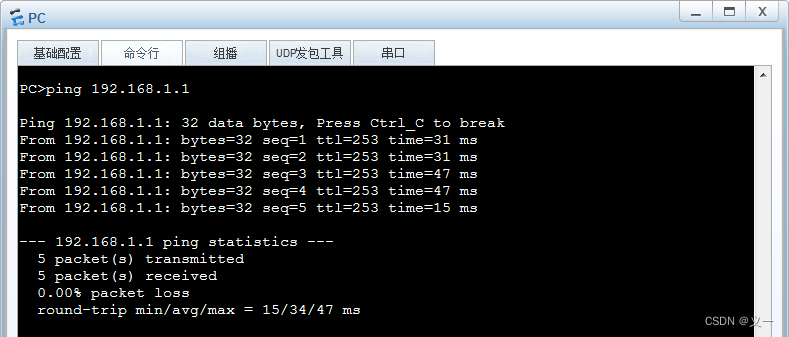

神经网络中防止过拟合

-

Dropout可以作为训练深度神经网络的一种trick供选择。在每个训练批次中,通过忽略一半的特征检测器(让一半的隐层节点值为0),可以明显地减少过拟合现象。这种方式可以减少特征检测器(隐层节点)间的相互作用,检测器相互作用是指某些检测器依赖其他检测器才能发挥作用。

Dropout说的简单一点就是:我们在前向传播的时候,让某个神经元的激活值以一定的概率p停止工作,这样可以使模型泛化性更强,因为它不会太依赖某些局部的特征