激活函数总结(四十六):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 Nipuna激活函数

- 2.2 StarReLU激活函数

- 3. 总结

1 引言

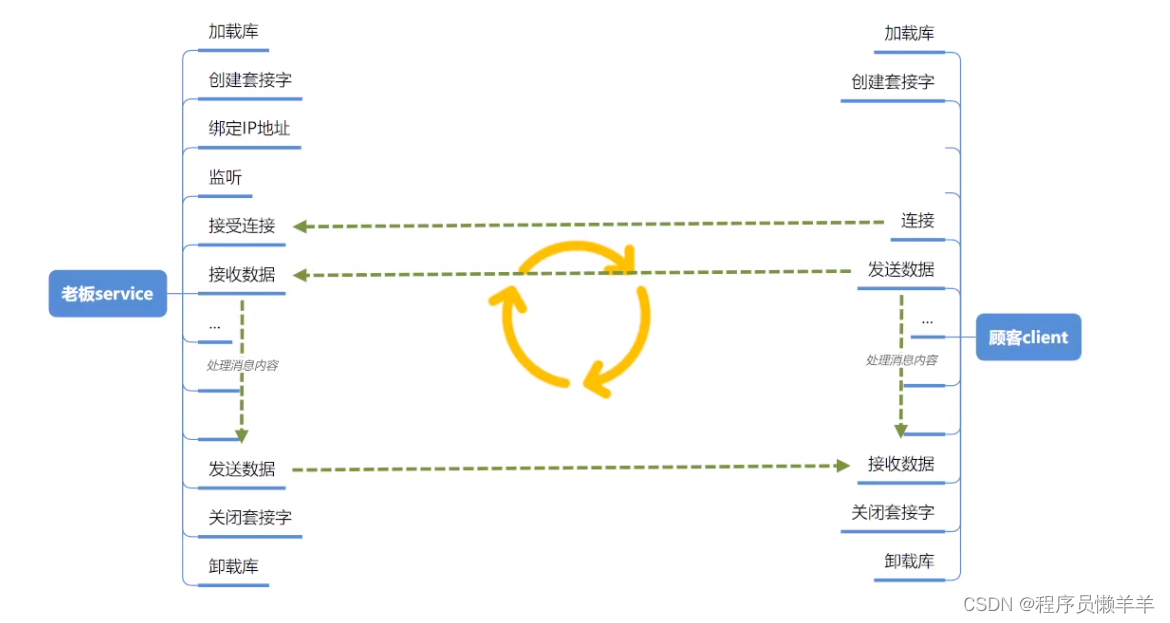

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、Threshold、Sinc、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU、PELU、Phish、RBF、SQ-RBF、ISRU、ISRLU、SQNL、PLU、APL、Inverse Cubic、Soft Exponential、ParametricLinear、Piecewise Linear Unit、CLL、SquaredReLU、ModReLU、CosReLU、SinReLU、Probit、Smish、Multiquadratic、InvMultiquadratic、PSmish、ESwish、CoLU、ShiftedSoftPlus、Logit、Softsign、ELiSH、Hard ELiSH、Serf、FReLU、QReLU、m-QReLU、FReLU、CReLU、KAF、Siren、ARiA、m-arcsinh、PAU、DELU、PDELU、CosLU、NFN、Hermite、AHAF、SERLU、ShiLU、ReLUN、SSFG、Gumbel Cross Entropy、ScaledSoftSign、NormLinComb、NLSIG、EvoNorms、Smooth Step、LinComb)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

2.1 Nipuna激活函数

论文链接:NIPUNA: A Novel Optimizer Activation Function for Deep Neural Networks

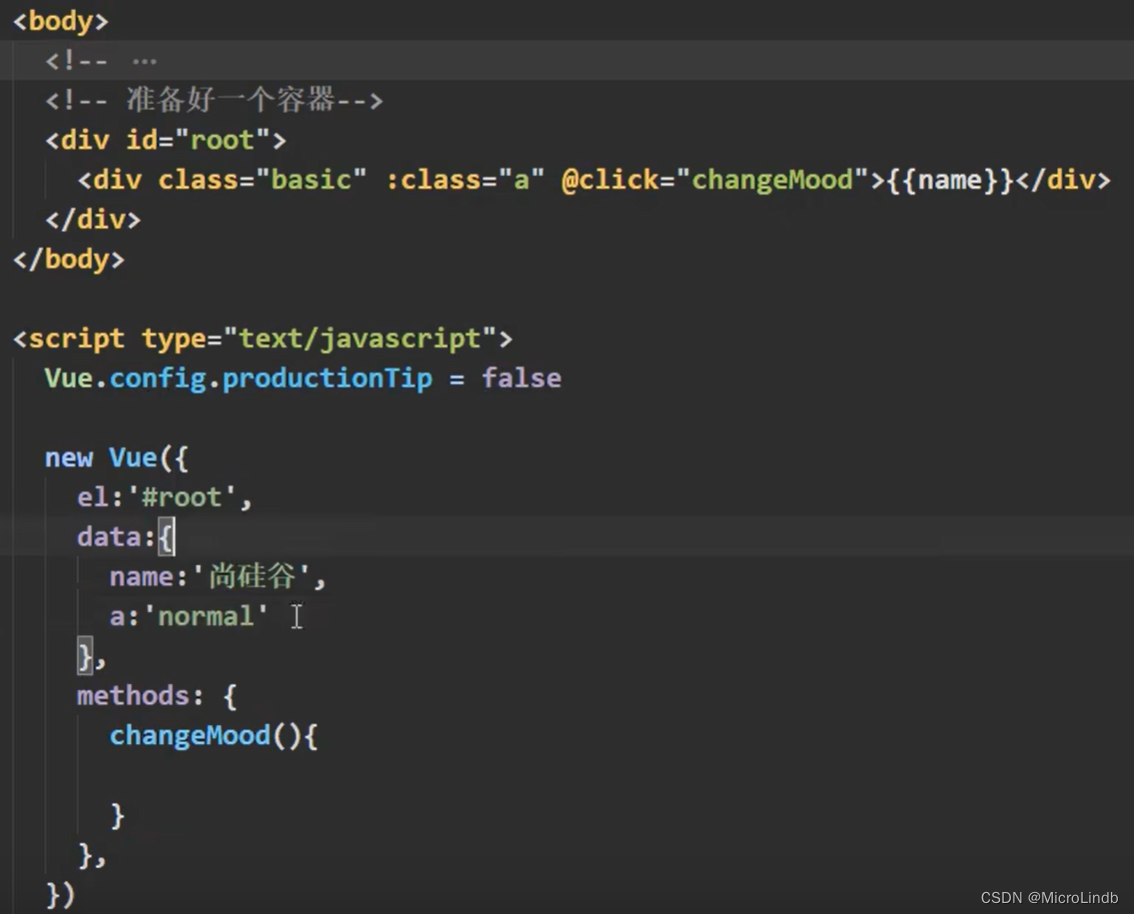

背景: 整流线性单元(ReLU)最近已成为最流行和广泛使用的激活函数。ReLU存在一些缺陷,例如,它仅在反向传播期间单位为正而为零时才处于活动状态。这导致神经元死亡(死亡的ReLU)和偏见的转变。但是,与ReLU激活函数不同,Swish激活函数不会保持稳定或向单个方向移动。这项研究提出了一种名为NIPUNA的新激活函数,用于深度神经网络。它结合了饱和和非饱和激活的优点。它显示了自门控整流线性单元,该单元由ReLU和Swish的自门控特性驱动。其数学表达式和数学图像分别如下所示:

f

(

x

)

=

m

a

x

(

(

g

(

x

)

,

x

)

)

g

(

x

)

=

x

1

+

e

−

β

x

f(x)=max((g(x),x)) \\ g(x)=\frac{x}{1+e^{-βx}}

f(x)=max((g(x),x))g(x)=1+e−βxx

优点:

- 分段特性:该函数具有

分段的特性,取 x x x 与 g ( x ) g(x) g(x) 的最大值 - 提升了一定的计算速度:它避免了

接近零梯度的缓慢训练时间

缺点:

- 计算速度较慢:存在

指数计算任务,在实际计算中会导致整体计算速度较慢

该激活函数较为简单,且具有一定的优势,但是实际中不建议使用。。。。(未经过实验验证和权威验证。。)

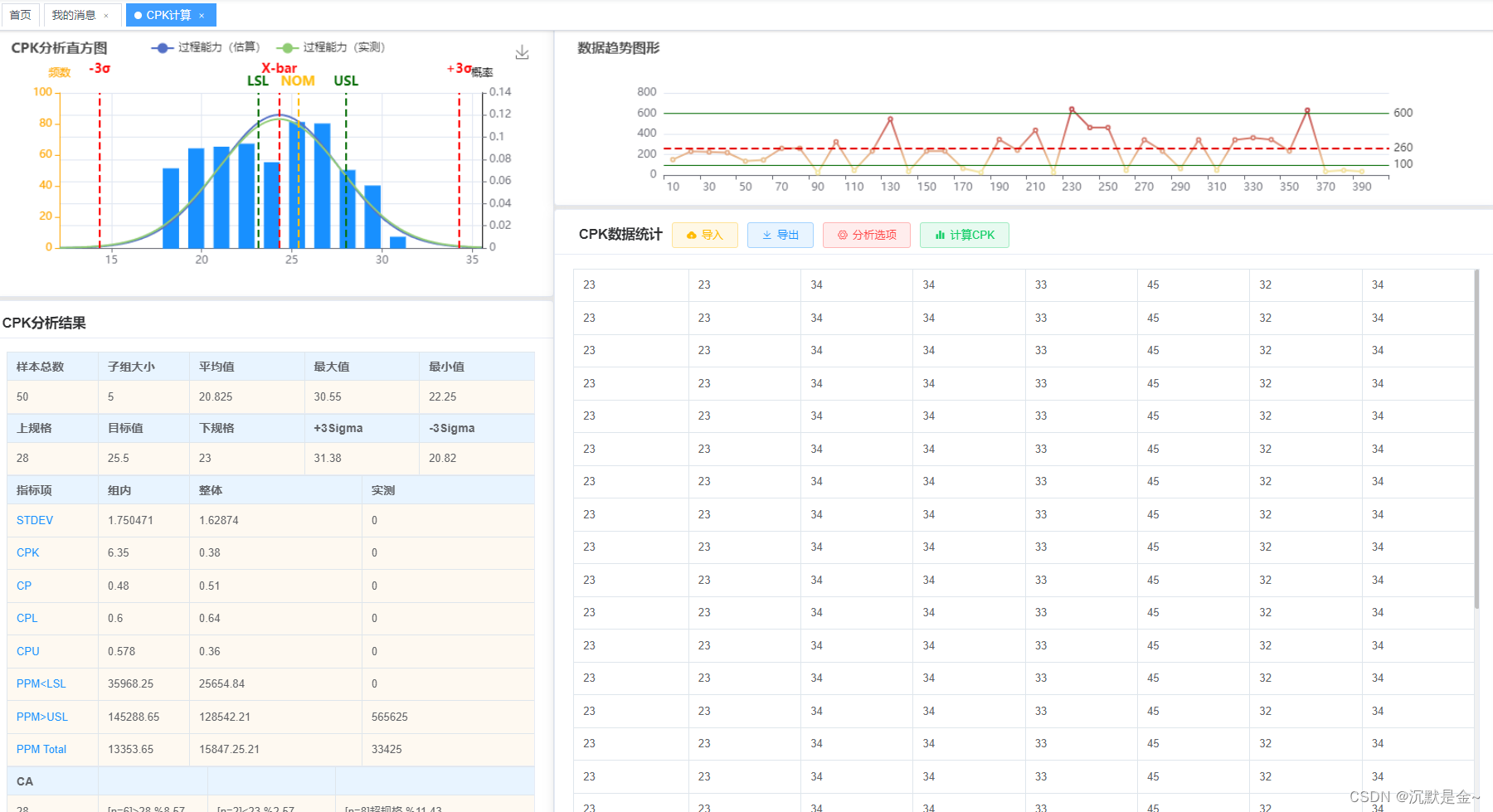

2.2 StarReLU激活函数

论文链接:MetaFormer Baselines for Vision

StarReLU 是 Squared ReLU 的变种,但特别设计用于缓解分布偏移。其数学表达式和数学图像分别如下所示:

S

t

a

r

R

e

L

U

(

x

)

=

s

⋅

(

R

e

L

U

(

x

)

)

2

+

b

StarReLU(x) = s \cdot (\mathrm{ReLU}(x))^2 + b

StarReLU(x)=s⋅(ReLU(x))2+b

其中,参数

s

s

s 和

b

b

b 是所有通道共享的参数,可以设置为常量(

s

=

0.8944

,

b

=

−

0.4472

s=0.8944,b=-0.4472

s=0.8944,b=−0.4472)或可学习的参数。

特点:

- 运行速度快:与GELU相比,StarReLU减少了

71%的激活FLOP - 精度高:与GELU相比,StarReLU实现了

更好的性能。

该激活函数在MetaFormer 中得到应用,同时,MetaFormer 是一种优秀的结构。因此,该激活函数可以被考虑用来提高模型精度,有需要的人可以考虑。。。 欢迎feedback

3. 总结

到此,使用 激活函数总结(四十六) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。